Command Palette

Search for a command to run...

3EED 语言驱动三维理解数据集

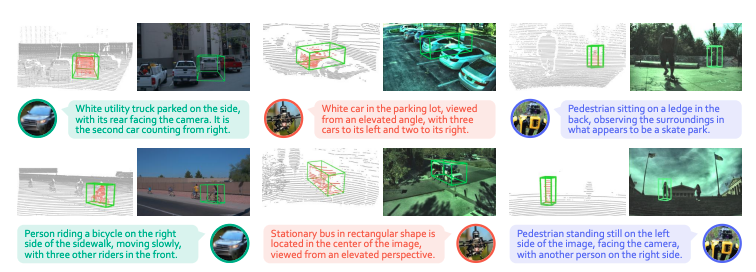

3EED 是由香港科技大学(广州)联合南洋理工大学、香港科技大学等机构于 2025 年发布的一个多平台、多模态三维视觉指代(3D Grounding)数据集,相关论文成果为「3EED: Ground Everything Everywhere in 3D」,已被 NeurIPS 2025 接受,旨在支持模型在真实户外场景中完成语言驱动 3D 目标定位的任务,并全面评估模型的跨平台鲁棒性与空间理解能力。

该数据集共包含 20,367 个时间对齐的多模态帧,覆盖车辆(Vehicle)、无人机(Drone)与四足机器人(Quadruped)三类平台,提供 128,735 个三维目标框以及 22,439 条人工验证的语言指代表达,规模较现有同类型数据集扩大近 10 倍。同时,数据场景空间范围可达 280 m × 240 m × 80+ m,比既有户外三维指代数据集大一个数量级,为研究远距离、多尺度、多视角的真实三维理解提供了独特条件。