Command Palette

Search for a command to run...

Minh-Thang Luong; Hieu Pham; Christopher D. Manning

摘要

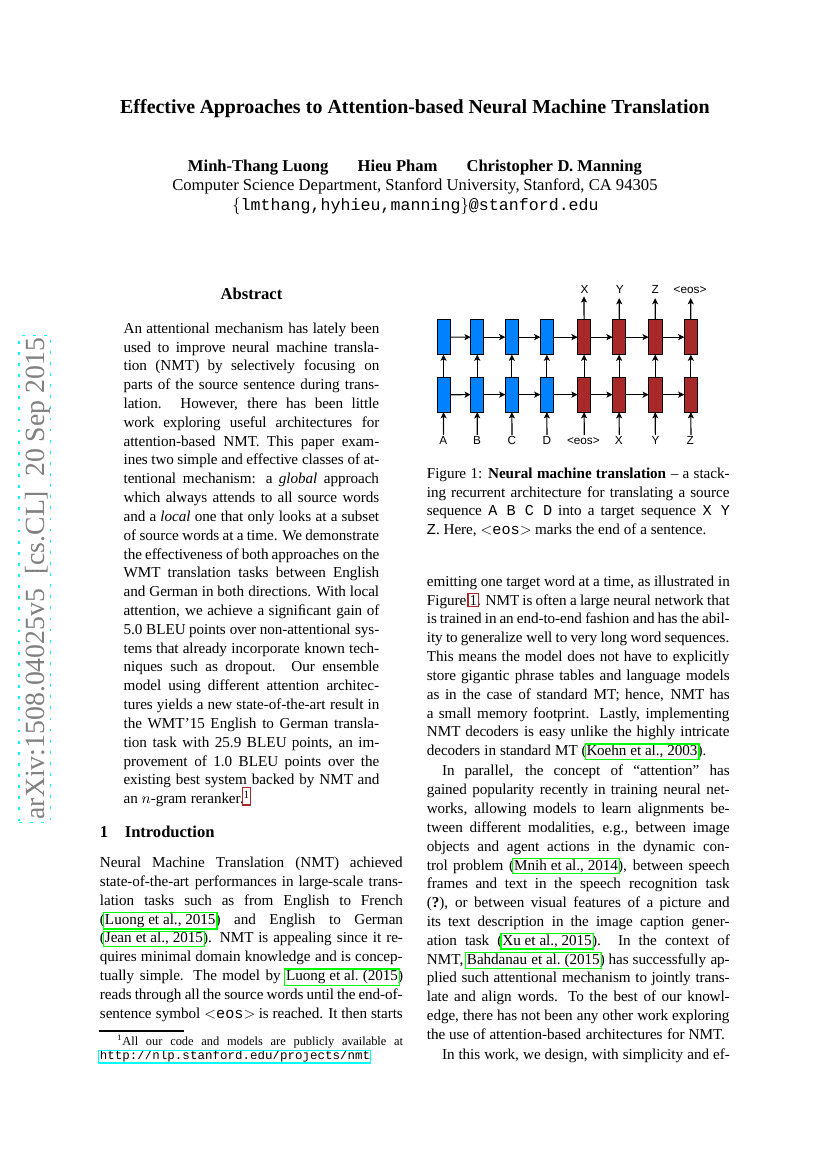

近期,注意力机制被用于改进神经机器翻译(NMT),通过在翻译过程中有选择性地关注源句子的某些部分来提升性能。然而,关于适用于基于注意力机制的NMT的有效架构的研究相对较少。本文探讨了两类简单且有效的注意力机制:一种是全局方法,始终关注所有源词;另一种是局部方法,每次仅关注源词的一个子集。我们在这两种方法上展示了其在WMT英德双向翻译任务中的有效性。利用局部注意力机制,我们在已集成诸如dropout等已知技术的非注意力系统基础上实现了显著的5.0个BLEU分的提升。通过结合不同注意力架构的模型集合,我们在WMT'15英德翻译任务中取得了25.9个BLEU分的新最佳结果,比现有的最佳系统(该系统基于NMT和n-gram重排序器)提高了1.0个BLEU分。

代码仓库

基准测试

| 基准 | 方法 | 指标 |

|---|---|---|

| image-guided-story-ending-generation-on-lsmdc | Seq2Seq | BLEU-1: 14.21 BLEU-2: 4.56 BLEU-3: 1.70 BLEU-4: 0.70 CIDEr: 8.69 METEOR: 11.01 ROUGE-L: 19.69 |

| image-guided-story-ending-generation-on-vist | Seq2Seq | BLEU-1: 13.96 BLEU-2: 5.57 BLEU-3: 2.94 BLEU-4: 1.69 CIDEr: 12.04 METEOR: 4.54 ROUGE-L: 16.84 |

| machine-translation-on-20news | 12 | Accuracy: 1.0 |

| machine-translation-on-wmt2014-english-german | RNN Enc-Dec Att | BLEU score: 20.9 Hardware Burden: Operations per network pass: |

| machine-translation-on-wmt2014-english-german | RNN Enc-Dec | BLEU score: 11.3 Hardware Burden: Operations per network pass: |

| machine-translation-on-wmt2014-english-german | Reverse RNN Enc-Dec | BLEU score: 14.0 Hardware Burden: Operations per network pass: |