Command Palette

Search for a command to run...

Serena Yeung Olga Russakovsky Greg Mori Li Fei-Fei

摘要

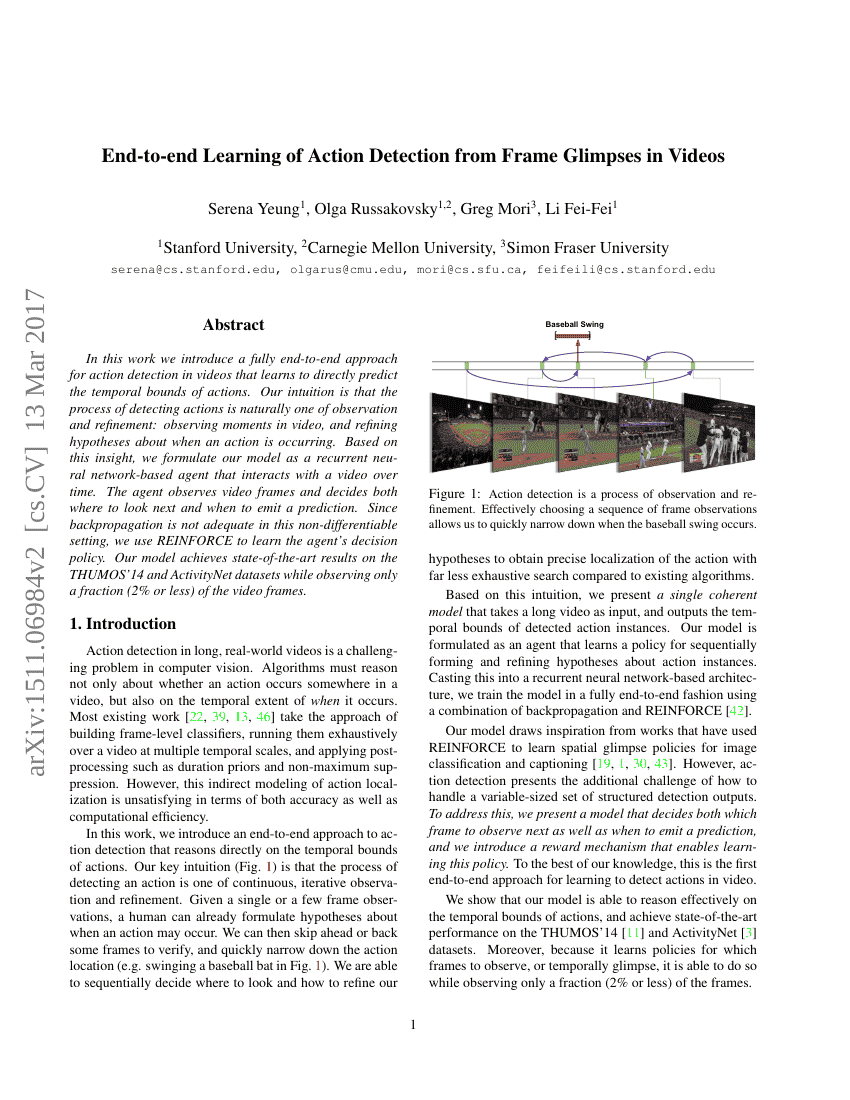

在本研究中,我们提出了一种完全端到端的方法,用于视频中的动作检测,该方法能够直接预测动作的时间边界。我们的直觉是,动作检测的过程本质上是一个观察和细化的过程:观察视频中的时刻,并不断修正关于动作发生时间的假设。基于这一见解,我们将模型设计为一个基于循环神经网络的智能体,该智能体能够在时间上与视频进行交互。智能体观察视频帧,并决定下一步观察的位置以及何时输出预测。由于反向传播在这种非可微环境中并不适用,我们使用REINFORCE算法来学习智能体的决策策略。我们的模型在THUMOS'14和ActivityNet数据集上取得了最先进的结果,同时仅观察了视频帧的一小部分(2%或更少)。

代码仓库

syyeung/frameglimpses

pytorch

GitHub 中提及

基准测试

| 基准 | 方法 | 指标 |

|---|---|---|

| action-recognition-in-videos-on-thumos14 | Yeung et. al. | [email protected]: 48.9 [email protected]: 44.0 [email protected]: 36.0 [email protected]: 26.4 [email protected]: 17.1 |

| temporal-action-localization-on-thumos14 | Yeung et al. | mAP [email protected]: 48.9 mAP [email protected]: 44.0 mAP [email protected]: 36.0 mAP [email protected]: 26.4 mAP [email protected]: 17.1 |