Command Palette

Search for a command to run...

Yuri Burda* OpenAI Harrison Edwards* OpenAI Amos Storkey Univ. of Edinburgh Oleg Klimov OpenAI

摘要

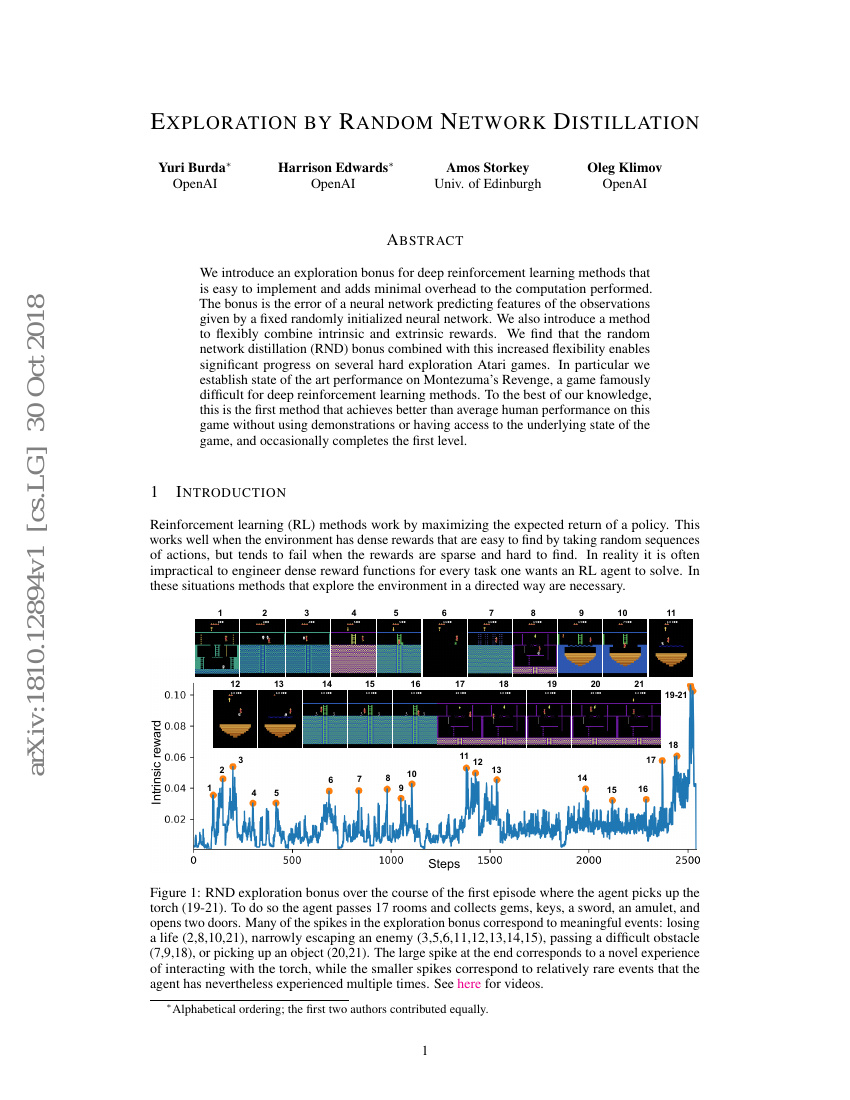

我们提出了一种适用于深度强化学习方法的探索奖励机制,该机制易于实现且对计算过程增加的额外开销极小。这种奖励是基于一个固定随机初始化神经网络预测观察特征时产生的误差。此外,我们还引入了一种灵活结合内在奖励和外在奖励的方法。研究发现,随机网络蒸馏(Random Network Distillation, RND)奖励与这种增强的灵活性相结合,在多个需要艰难探索的Atari游戏中取得了显著进展。特别是在Montezuma's Revenge这款游戏中,该方法达到了业界领先的表现,这款游戏以其对深度强化学习方法的巨大挑战而闻名。据我们所知,这是首个无需使用演示数据或访问游戏底层状态即可超越人类平均水平表现的方法,并且偶尔能够完成第一关。

代码仓库

基准测试

| 基准 | 方法 | 指标 |

|---|---|---|

| atari-games-on-atari-2600-gravitar | RND | Score: 3906 |

| atari-games-on-atari-2600-montezumas-revenge | RND | Score: 8152 |

| atari-games-on-atari-2600-pitfall | RND | Score: -3 |

| atari-games-on-atari-2600-private-eye | RND | Score: 8666 |

| atari-games-on-atari-2600-solaris | RND | Score: 3282 |

| atari-games-on-atari-2600-venture | RND | Score: 1859 |