Command Palette

Search for a command to run...

Andreas Rössler Davide Cozzolino Luisa Verdoliva Christian Riess Justus Thies Matthias Nießner

摘要

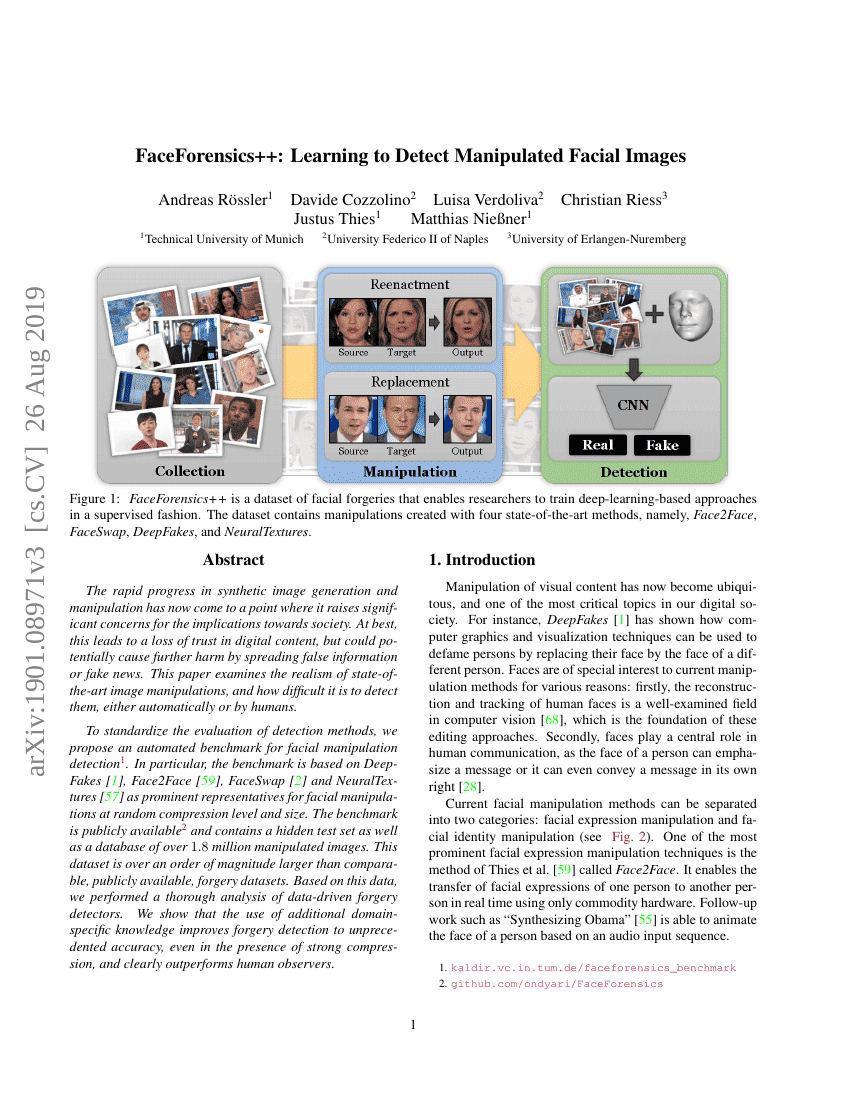

合成图像生成和操纵技术的迅速发展已经达到了一个引发社会重大关切的阶段。最坏的情况是导致对数字内容的信任度下降,但更严重的是可能通过传播虚假信息或假新闻造成进一步的危害。本文研究了最先进的图像操纵技术的真实性和检测难度,无论是自动检测还是人工识别。为了标准化检测方法的评估,我们提出了一种用于面部操纵检测的自动化基准测试。特别是,该基准测试基于DeepFakes、Face2Face、FaceSwap和NeuralTextures(这些是面部操纵的突出代表),在不同的压缩水平和尺寸下进行测试。该基准测试公开可用,并包含一个隐藏的测试集以及超过180万张被操纵的图像数据库。这一数据集比现有的、公开的伪造数据集大了一个数量级以上。基于这些数据,我们对数据驱动的伪造检测器进行了详尽分析。结果显示,使用额外的领域特定知识可以显著提高伪造检测的准确性,即使在强压缩的情况下也能达到前所未有的精度,并且明显优于人类观察者。

代码仓库

基准测试

| 基准 | 方法 | 指标 |

|---|---|---|

| deepfake-detection-on-faceforensics | XceptionNet | DF: 96.36 FS: 90.29 FSF: 86.86 NT: 80.67 Real: 52.4 Total Accuracy: 70.1 |

| deepfake-detection-on-fakeavceleb-1 | Xception | AP: 84.8 ROC AUC: 85.3 |