Command Palette

Search for a command to run...

Neil Houlsby Andrei Giurgiu* Stanisław Jastrzębski* Bruna Morrone Quentin de Laroussilhe Andrea Gesmundo Mona Attariyan Sylvain Gelly

摘要

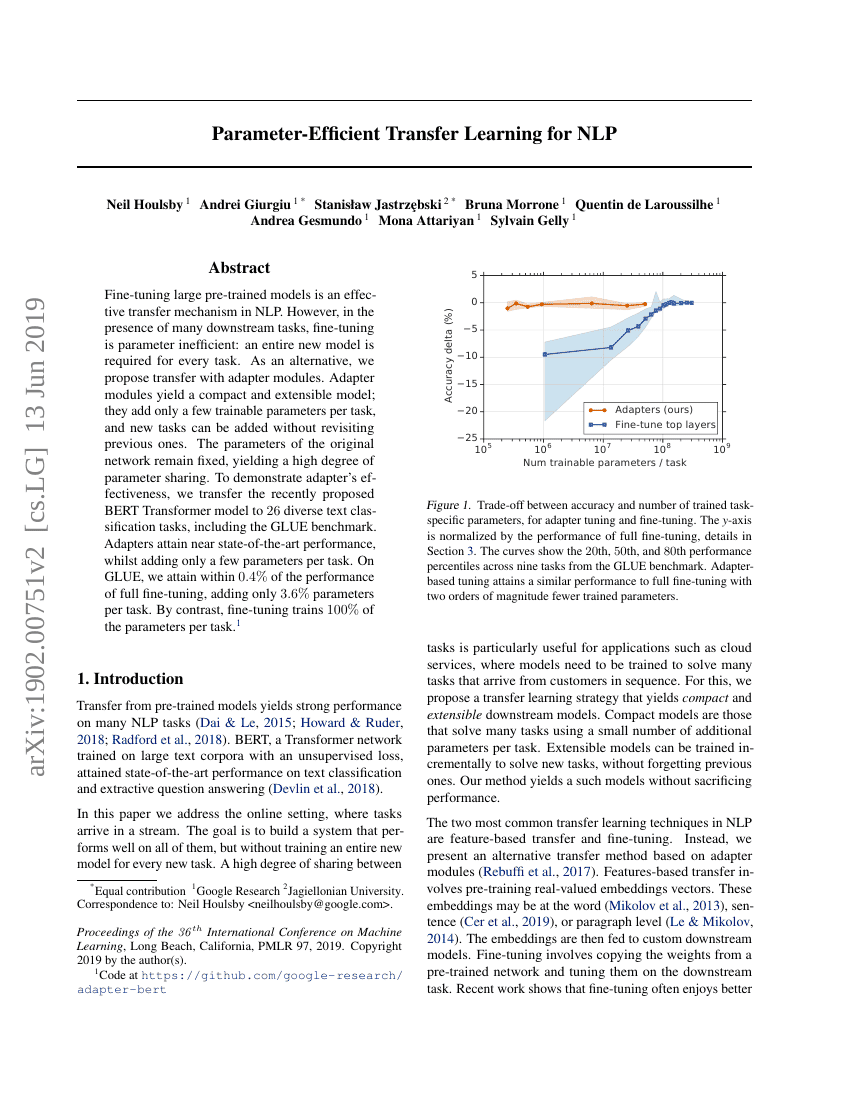

微调大型预训练模型是自然语言处理(NLP)中一种有效的迁移机制。然而,在面对众多下游任务时,微调在参数效率方面存在不足:每个任务都需要一个全新的模型。作为替代方案,我们提出使用适配器模块进行迁移。适配器模块能够生成紧凑且可扩展的模型;它们为每个任务仅增加少量可训练参数,并且可以在不重新审视先前任务的情况下添加新任务。原始网络的参数保持固定,从而实现高度的参数共享。为了展示适配器的有效性,我们将最近提出的BERT Transformer模型迁移到26个不同的文本分类任务上,包括GLUE基准测试。实验结果表明,适配器在每个任务上仅增加少量参数的情况下,达到了接近最先进水平的性能。在GLUE基准测试中,我们的方法在性能上仅比完全微调低0.4%,但每个任务仅增加了3.6%的参数。相比之下,完全微调则需要对每个任务训练100%的参数。

代码仓库

基准测试

| 基准 | 方法 | 指标 |

|---|---|---|

| image-classification-on-omnibenchmark | Adapter-ViTB/16 | Average Top-1 Accuracy: 44.5 |