Command Palette

Search for a command to run...

Jiaming Sun extsuperscript{1,2} extsuperscript{*} Zehong Shen extsuperscript{1} extsuperscript{*} Yuang Wang extsuperscript{1} extsuperscript{*} Hujun Bao extsuperscript{1} Xiaowei Zhou extsuperscript{1} extsuperscript{†}

摘要

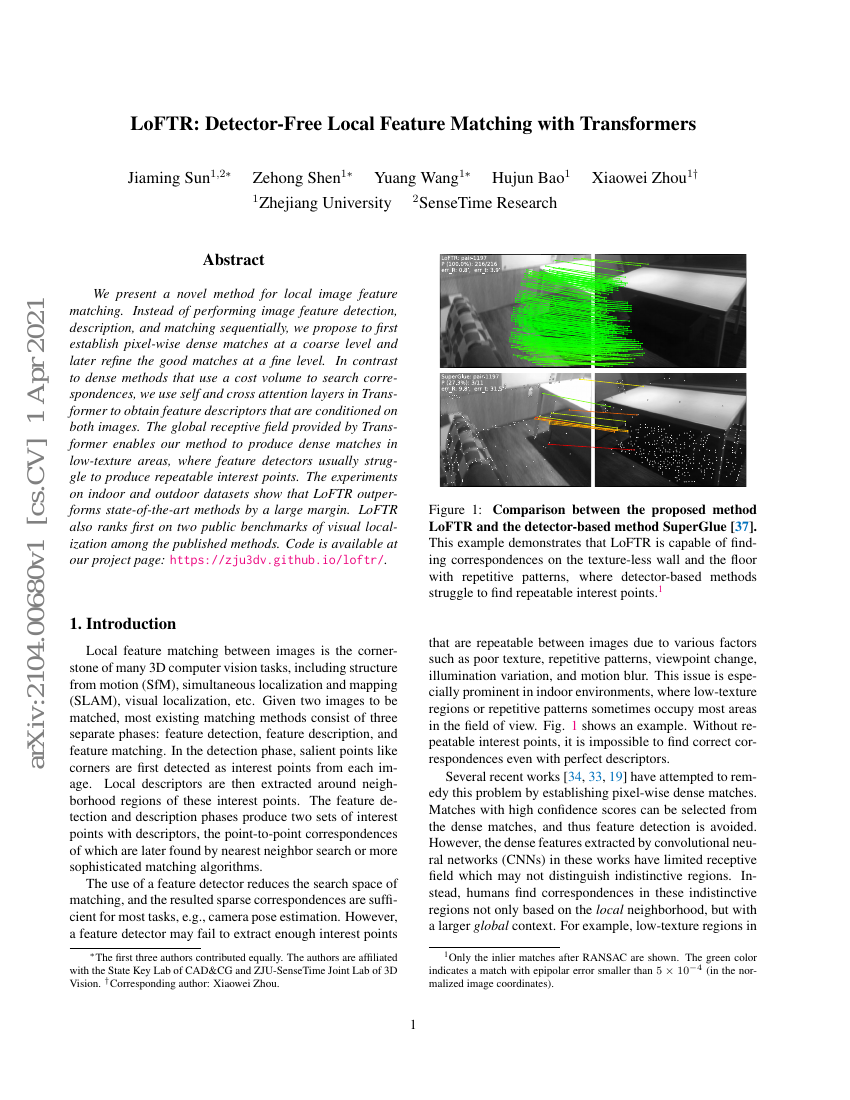

我们提出了一种新的局部图像特征匹配方法。与传统的依次进行图像特征检测、描述和匹配的方法不同,我们建议首先在粗略级别上建立像素级密集匹配,然后在精细级别上进一步优化这些良好的匹配。与使用成本体积来搜索对应关系的密集方法相比,我们利用Transformer中的自注意力层和交叉注意力层来获取依赖于两幅图像的特征描述符。Transformer提供的全局感受野使我们的方法能够在低纹理区域生成密集匹配,而这些区域通常是特征检测器难以产生可重复兴趣点的地方。在室内和室外数据集上的实验表明,LoFTR显著优于现有最先进方法。此外,在已发表的方法中,LoFTR还在两个公开的视觉定位基准测试中排名第一。

代码仓库

kornia/kornia

pytorch

fabio-sim/DeDoDe-ONNX-TensorRT

pytorch

GitHub 中提及

kolkir/coarse_loftr_trt

pytorch

GitHub 中提及

zju3dv/LoFTR

官方

pytorch

GitHub 中提及

基准测试

| 基准 | 方法 | 指标 |

|---|---|---|

| image-matching-on-zeb | LoFTR | Mean AUC@5°: 33.1 |

| pose-estimation-on-inloc | LoFTR | [email protected],10°: 47.5 [email protected],10°: 72.2 [email protected],10°: 84.8 [email protected],10°: 54.2 [email protected],10°: 74.8 [email protected],10°: 82.5 |

| visual-localization-on-aachen-day-night-v1-1 | LoFTR |