Command Palette

Search for a command to run...

摘要

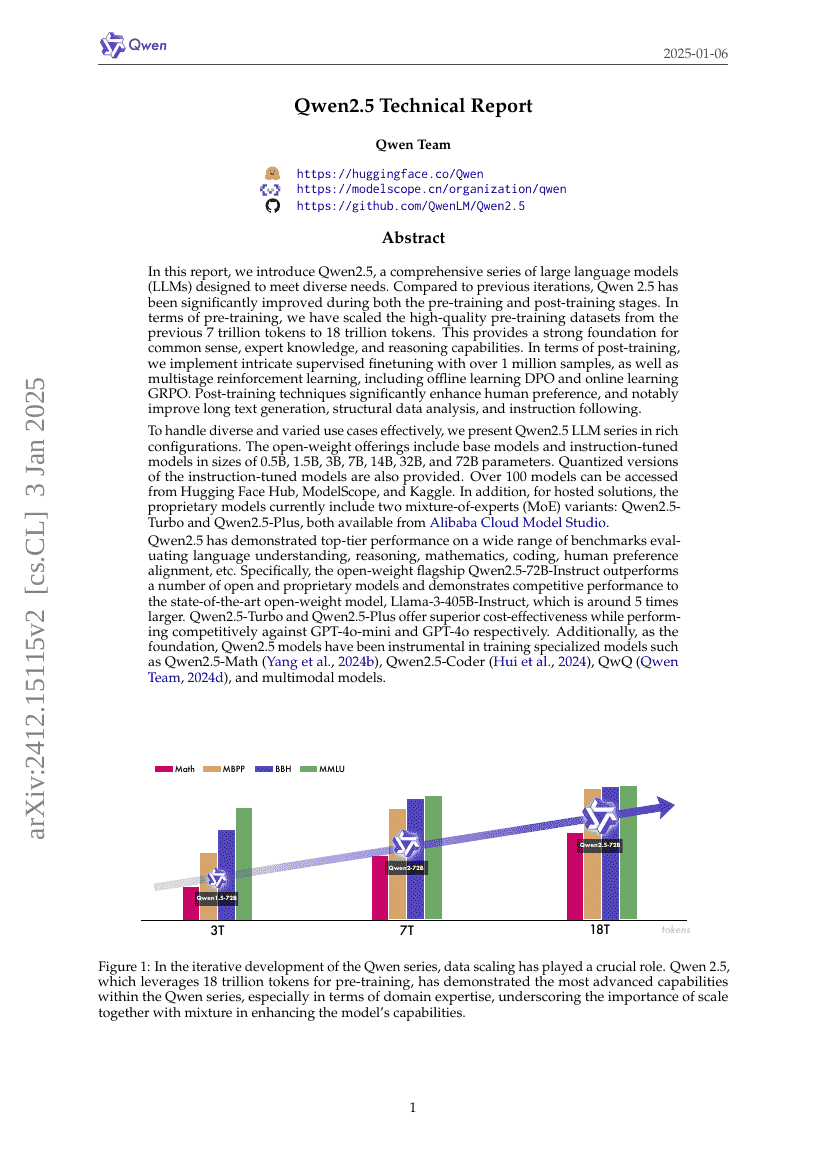

在本报告中,我们推出Qwen2.5,这是一系列全面的大型语言模型(LLMs),旨在满足多样化的应用需求。相较于此前版本,Qwen2.5在预训练和后训练两个阶段均实现了显著提升。在预训练方面,我们已将高质量预训练数据集从此前的7万亿个token扩展至18万亿个token,为模型在常识理解、专业知识和推理能力方面奠定了坚实基础。在后训练阶段,我们采用了包含超过100万样本的复杂监督微调(Supervised Fine-tuning),并结合多阶段强化学习(Reinforcement Learning)方法。这些后训练技术有效增强了模型对人类偏好的对齐能力,尤其在长文本生成、结构化数据解析和指令遵循等方面表现突出。为有效应对多样且复杂的使用场景,我们推出了多种规模的Qwen2.5大模型系列。开放权重版本包括基础模型(base models)和指令微调模型(instruction-tuned models),并提供量化版本以适应不同部署需求。此外,针对托管式解决方案,当前已上线两款基于混合专家(Mixture-of-Experts, MoE)架构的专有模型:Qwen2.5-Turbo与Qwen2.5-Plus,均可通过阿里云Model Studio获取。Qwen2.5在涵盖语言理解、推理能力、数学计算、代码生成、人类偏好对齐等多个维度的广泛基准测试中,均展现出顶级性能。具体而言,其开放权重旗舰模型Qwen2.5-72B-Instruct在多项指标上超越了多个开源及闭源模型,性能可与当前最先进的开源模型Llama-3-405B-Instruct相媲美,而后者参数量约为Qwen2.5-72B-Instruct的5倍。Qwen2.5-Turbo与Qwen2.5-Plus在保持卓越性能的同时,分别在成本效益上优于GPT-4o-mini和GPT-4o,展现出极强的竞争力。此外,作为基础模型,Qwen2.5已广泛用于训练多个垂直领域专用模型,包括Qwen2.5-Math(数学专项)、Qwen2.5-Coder(代码生成)、QwQ(多轮对话与推理)以及多模态模型,充分体现了其在构建下一代AI系统中的核心支撑作用。

代码仓库

基准测试

| 基准 | 方法 | 指标 |

|---|---|---|

| mathematical-reasoning-on-aime24 | Qwen2.5-72B-Instruct | Acc: 23.3 |