Command Palette

Search for a command to run...

Niklas Muennighoff Zitong Yang Weijia Shi Xiang Lisa Li Li Fei-Fei Hannaneh Hajishirzi Luke Zettlemoyer Percy Liang Emmanuel Candès Tatsunori Hashimoto

摘要

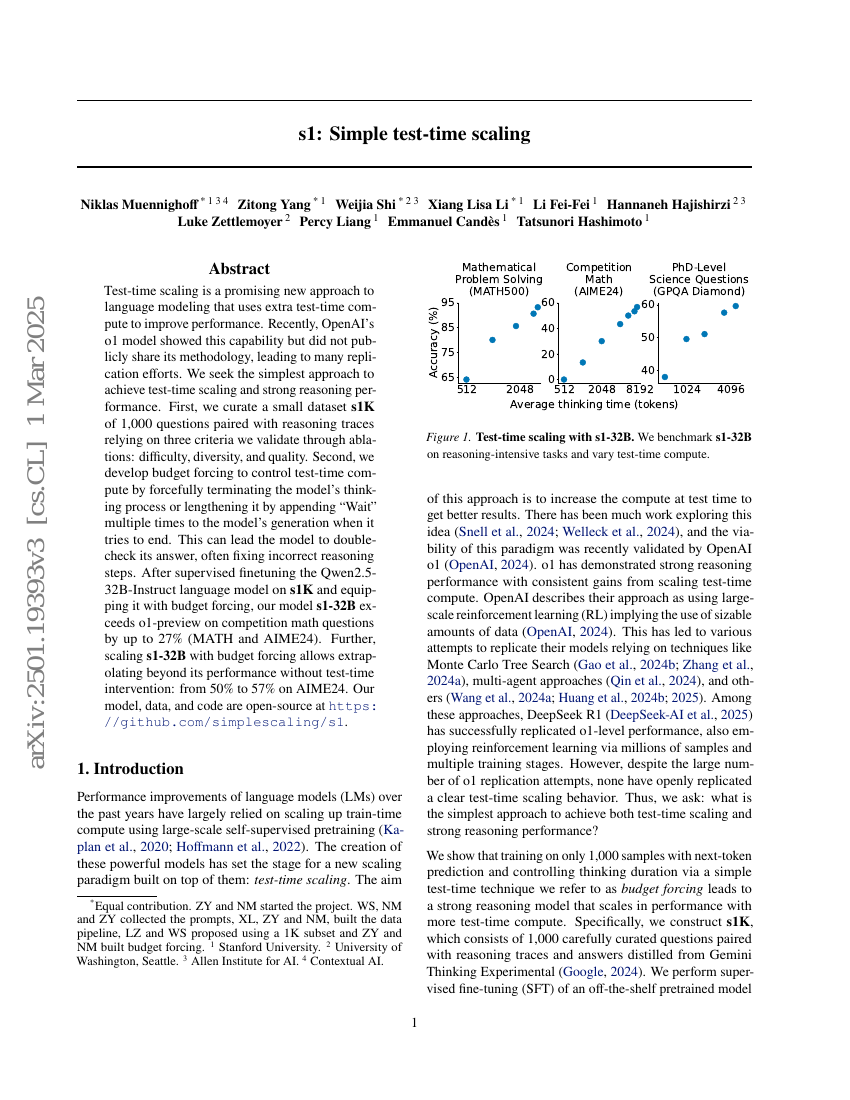

测试时扩展(Test-time scaling)是一种语言建模的有前景新方法,通过在测试阶段引入额外的计算资源来提升模型性能。近期,OpenAI 的 o1 模型展示了这一能力,但未公开其具体方法,从而引发了大量复现尝试。我们致力于探索实现测试时扩展与强大推理能力的最简方法。首先,我们构建了一个名为 s1K 的小型数据集,包含 1,000 个问题及其对应的推理过程,其筛选基于三个经消融实验验证的关键标准:难度、多样性与质量。其次,我们提出“预算强制”(budget forcing)机制,通过强制终止模型的思考过程,或在模型试图结束生成时反复添加“Wait”(等待)来延长其输出,从而有效控制测试阶段的计算开销。该机制可促使模型对答案进行复核,常能修正错误的推理步骤。在 s1K 数据集上对 Qwen2.5-32B-Instruct 语言模型进行监督微调,并结合预算强制机制后,我们的模型 s1 在竞赛类数学题上的表现超越了 o1-preview,最高提升达 27%(在 MATH 和 AIME24 数据集上)。此外,通过在预算强制机制下对 s1 进行扩展,可实现无需测试时干预的性能外推:在 AIME24 上从 50% 提升至 57%。我们的模型、数据集与代码已开源,地址为 https://github.com/simplescaling/s1。

代码仓库

基准测试

| 基准 | 方法 | 指标 |

|---|---|---|

| mathematical-reasoning-on-aime24 | s1-32B | Acc: 56.7 |