Command Palette

Search for a command to run...

Joya Chen Ziyun Zeng Yiqi Lin Wei Li Zejun Ma Mike Zheng Shou

摘要

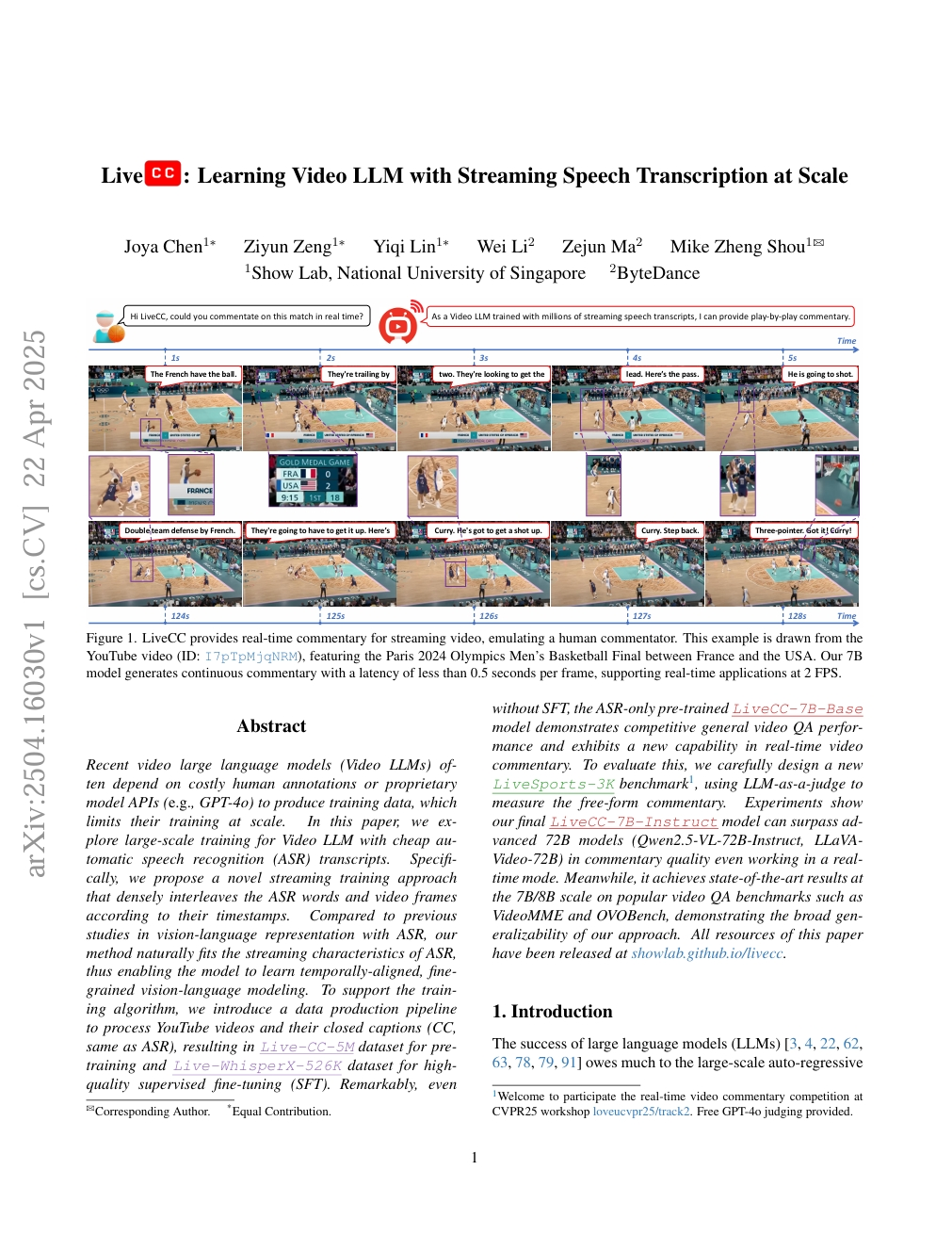

近期的视频大语言模型(Video LLMs)通常依赖于昂贵的人工标注数据或专有模型API(如GPT-4o)来生成训练数据,这限制了其大规模训练的可行性。本文探索了一种基于低成本自动语音识别(ASR)转录文本的大规模视频大语言模型训练方法。具体而言,我们提出了一种新颖的流式训练范式,该方法根据时间戳将ASR识别出的文本词与视频帧进行密集交错排列。相较于以往基于ASR的视觉-语言表征研究,我们的方法天然契合ASR的流式特性,从而使得模型能够学习到时间对齐、细粒度的视觉-语言建模能力。为支持该训练算法,我们构建了一套数据生成流水线,用于处理YouTube视频及其字幕(CC,等同于ASR转录文本),最终构建了用于预训练的Live-CC-5M数据集,以及用于高质量监督微调(SFT)的Live-WhisperX-526K数据集。值得注意的是,即使不经过SFT阶段,仅基于ASR数据预训练的LiveCC-7B-Base模型在通用视频问答任务中已展现出具有竞争力的性能,并首次展现出实时视频解说的新能力。为评估该能力,我们精心设计了一个新的基准测试集——LiveSports-3K,采用大语言模型作为裁判(LLM-as-a-judge)来衡量自由形式解说的质量。实验结果表明,我们的最终模型LiveCC-7B-Instruct在实时运行模式下,其解说质量已超越多个先进的72B参数规模模型(如Qwen2.5-VL-72B-Instruct、LLaVA-Video-72B)。同时,该模型在VideoMME和OVOBench等主流视频问答基准测试中,于7B/8B参数规模下均取得了当前最优性能,充分验证了本方法的广泛泛化能力。本文所有相关资源均已公开发布于以下网址:https://...。