Command Palette

Search for a command to run...

摘要

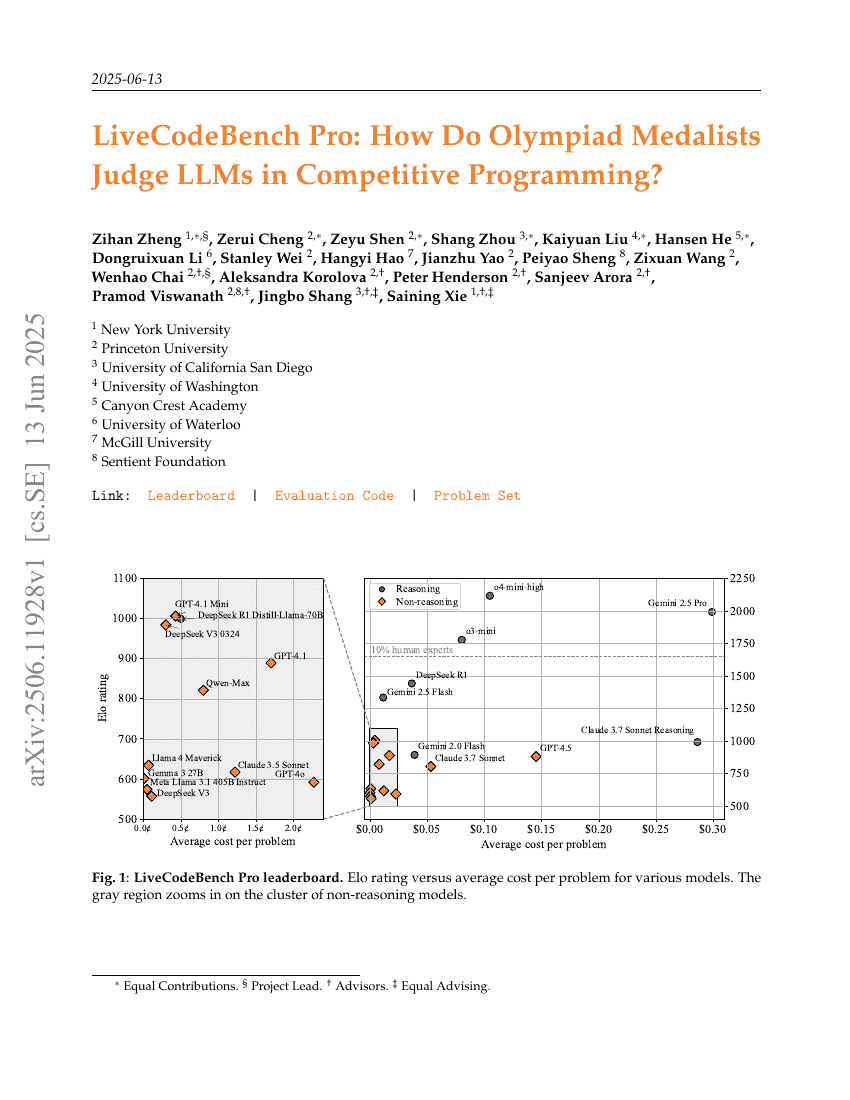

近期有报道称,大型语言模型(LLMs)在竞争编程中已经超越了顶尖人类选手。基于国际算法竞赛奖牌得主的知识,我们重新审视了这一说法,探讨了大型语言模型与人类专家之间的差异以及仍存在的局限性。我们引入了 LiveCodeBench Pro,这是一个由 Codeforces、ICPC 和 IOI 的问题组成的基准测试集,这些问题会持续更新以减少数据污染的可能性。一组奥林匹克奖牌得主对每个问题进行了算法类别的标注,并对失败的模型生成提交进行了逐行分析。通过这些新数据和基准测试,我们发现前沿模型仍然存在显著的局限性:在没有外部工具的情况下,最佳模型在中等难度问题上的 pass@1 成绩仅为 53%,而在高难度问题上则为 0%,而这些领域仍然是人类专家的强项。我们还发现,大型语言模型在实现密集型问题上表现出色,但在复杂的算法推理和复杂案例分析方面却显得力不从心,经常自信地生成错误的理由。高性能的表现主要归因于实现的精确性和工具增强,而不是优越的推理能力。因此,LiveCodeBench Pro 突显了与人类特级大师水平之间的显著差距,并提供了详细的诊断信息以指导未来代码中心型 LLM 推理的改进。