Command Palette

Search for a command to run...

Guang Yin Yitong Li Yixuan Wang Dale McConachie Paarth Shah Kunimatsu Hashimoto Huan Zhang Katherine Liu Yunzhu Li

摘要

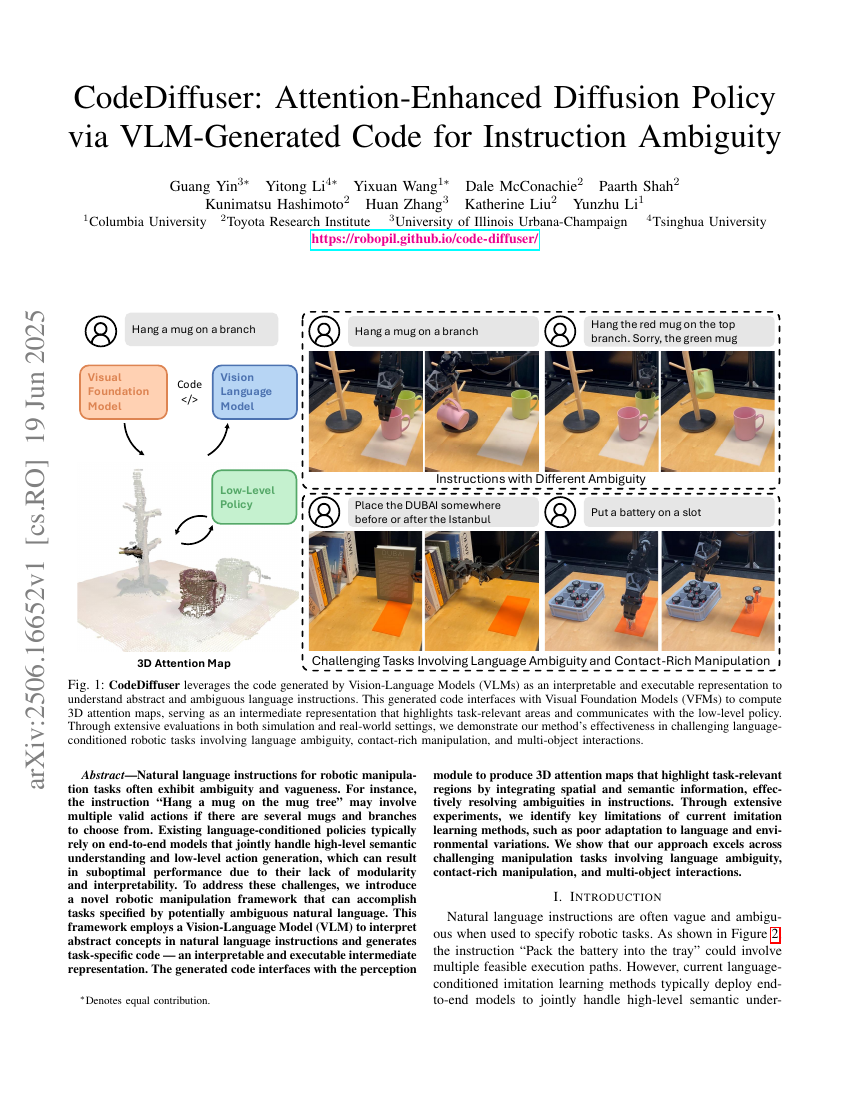

自然语言指令在机器人操作任务中通常表现出模糊性和不确定性。例如,指令“将杯子挂在杯架上”可能涉及多种有效动作,如果存在多个杯子和多个分支可供选择的话。现有的基于语言条件的策略通常依赖于端到端模型,这些模型同时处理高层次的语义理解和低层次的动作生成,但由于缺乏模块化和可解释性,可能导致性能不佳。为了解决这些挑战,我们提出了一种新的机器人操作框架,该框架能够完成由潜在模糊的自然语言指定的任务。该框架利用视觉-语言模型(Vision-Language Model, VLM)来解释自然语言指令中的抽象概念,并生成任务特定代码——一种可解释且可执行的中间表示。生成的代码与感知模块接口连接,通过整合空间和语义信息生成3D注意力图,突出显示任务相关区域,从而有效地解决指令中的模糊性问题。通过广泛的实验,我们识别了当前模仿学习方法的关键局限性,如对语言和环境变化的适应能力较差。我们展示了我们的方法在涉及语言模糊性、接触丰富的操作以及多对象交互的复杂操作任务中表现出色。