Command Palette

Search for a command to run...

摘要

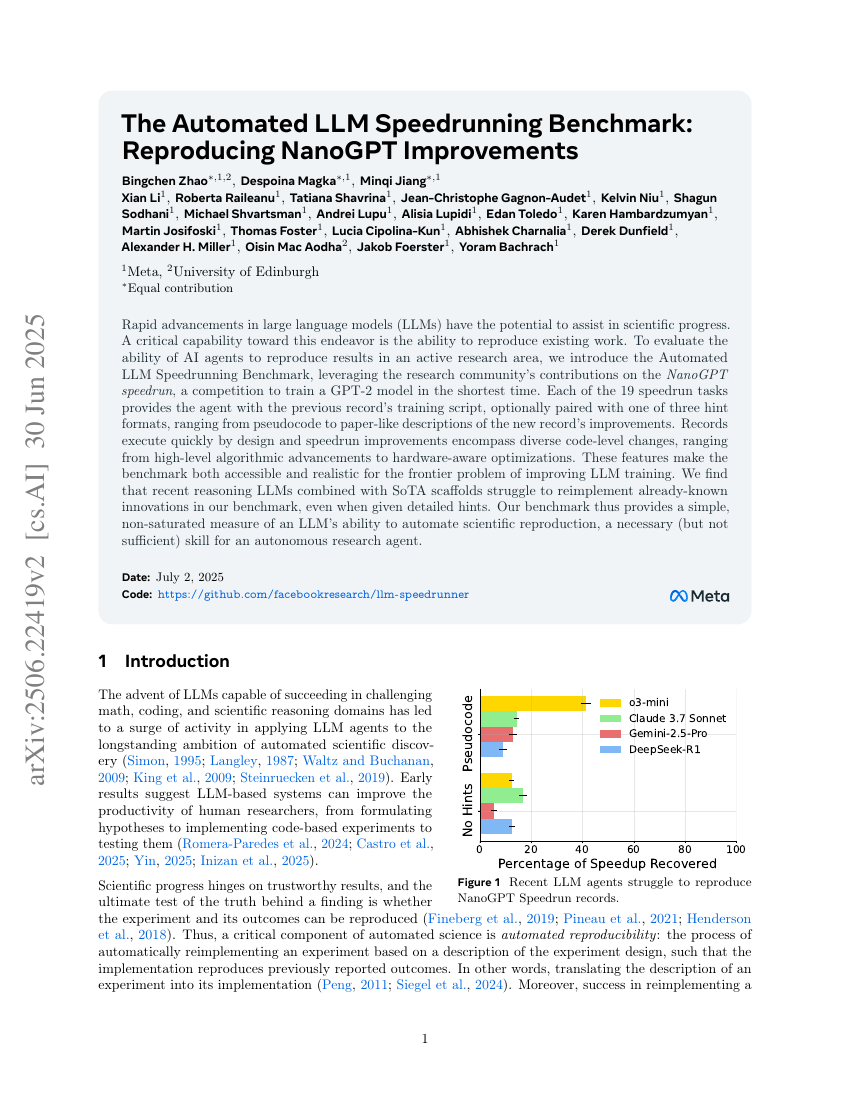

大型语言模型(LLMs)的快速进展有可能助力科学进步。实现这一目标的关键能力之一是能够复现现有工作。为了评估人工智能代理在活跃研究领域中复现结果的能力,我们引入了自动化LLM速通基准测试(Automated LLM Speedrunning Benchmark),该基准测试利用了纳米GPT速通竞赛(NanoGPT speedrun)中的研究社区贡献,这是一项旨在以最短时间训练GPT-2模型的比赛。该基准测试包含19个速通任务,每个任务都向代理提供之前的记录训练脚本,并可选择性地附带三种提示格式中的一种,这些提示格式从伪代码到类似论文的描述,涵盖了新记录改进的各种细节。这些记录设计上执行速度很快,而速通改进则包括多样的代码级变更,从高层次的算法改进到硬件感知优化不一而足。这些特点使得该基准测试既易于访问又具有现实性,适用于前沿问题——即如何改进LLM的训练过程。我们发现,即使提供了详细的提示,最近的推理型LLM结合最先进的框架(SoTA scaffolds)仍然难以在我们的基准测试中重新实现已知的创新。因此,我们的基准测试为评估LLM自动复现科学研究的能力提供了一个简单且未饱和的度量标准,这是自主研究代理所需的一项必要(但非充分)技能。