Command Palette

Search for a command to run...

Wenyi Hong Wenmeng Yu Xiaotao Gu Guo Wang Guobing Gan Haomiao Tang Jiale Cheng Ji Qi

摘要

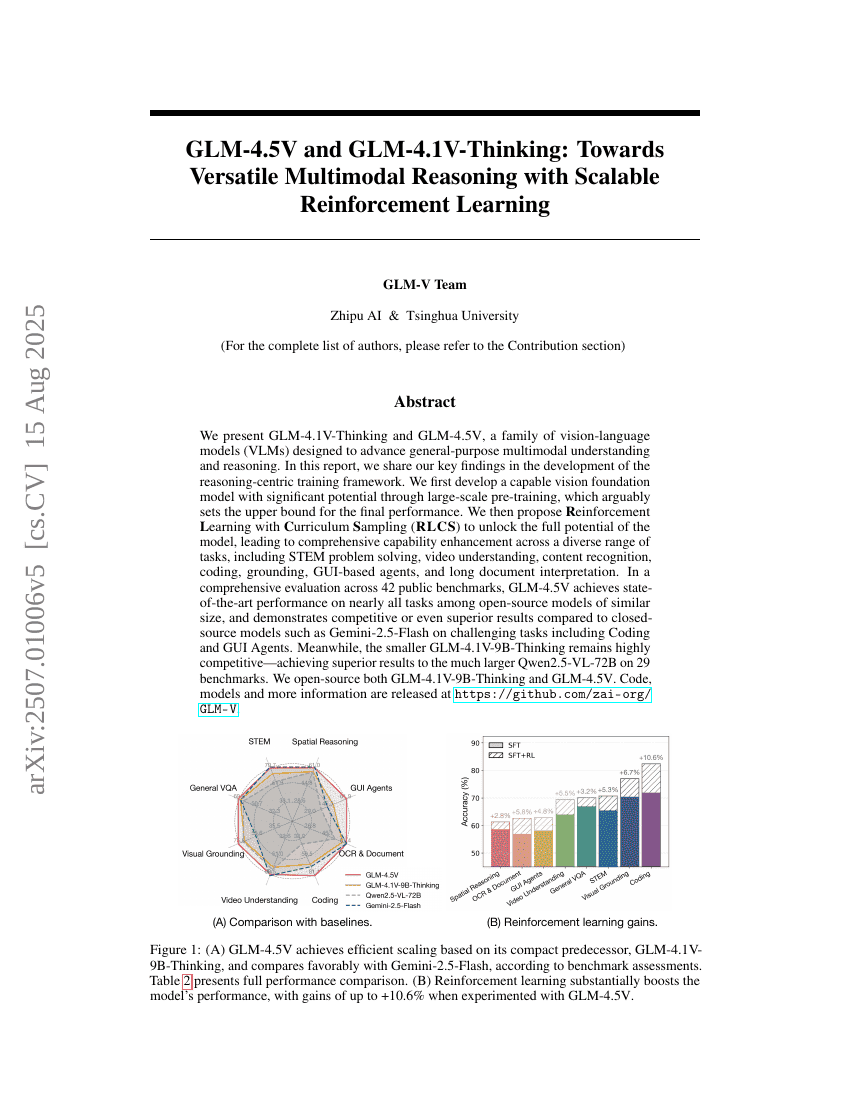

我们介绍了GLM-4.1V-Thinking,这是一种旨在推进通用多模态理解和推理的视觉-语言模型(VLM)。在本报告中,我们分享了在以推理为中心的训练框架开发过程中的关键发现。首先,我们通过大规模预训练开发了一个具有显著潜力的视觉基础模型,该模型被认为设定了最终性能的上限。随后,我们提出了强化学习与课程采样(Reinforcement Learning with Curriculum Sampling, RLCS)相结合的方法,以充分挖掘模型的潜力,从而在包括STEM问题解决、视频理解、内容识别、编程、指代消解、基于GUI的代理和长文档理解等多样化的任务中实现全面的能力提升。我们开源了GLM-4.1V-9B-Thinking模型,其在同等规模的模型中实现了最先进的性能。在对28个公开基准进行全面评估后,我们的模型在几乎所有任务上均优于Qwen2.5-VL-7B,并且在18个基准测试中相对于显著更大的Qwen2.5-VL-72B表现出相当或更优的性能。值得注意的是,GLM-4.1V-9B-Thinking在长文档理解和STEM推理等挑战性任务上也展现出与闭源模型如GPT-4o相匹敌或更优的性能,进一步突显了其强大的能力。代码、模型及相关信息已发布于此https URL。