Command Palette

Search for a command to run...

Tiezheng Zhang Yitong Li Yu-cheng Chou Jieneng Chen Alan Yuille Chen Wei Junfei Xiao

摘要

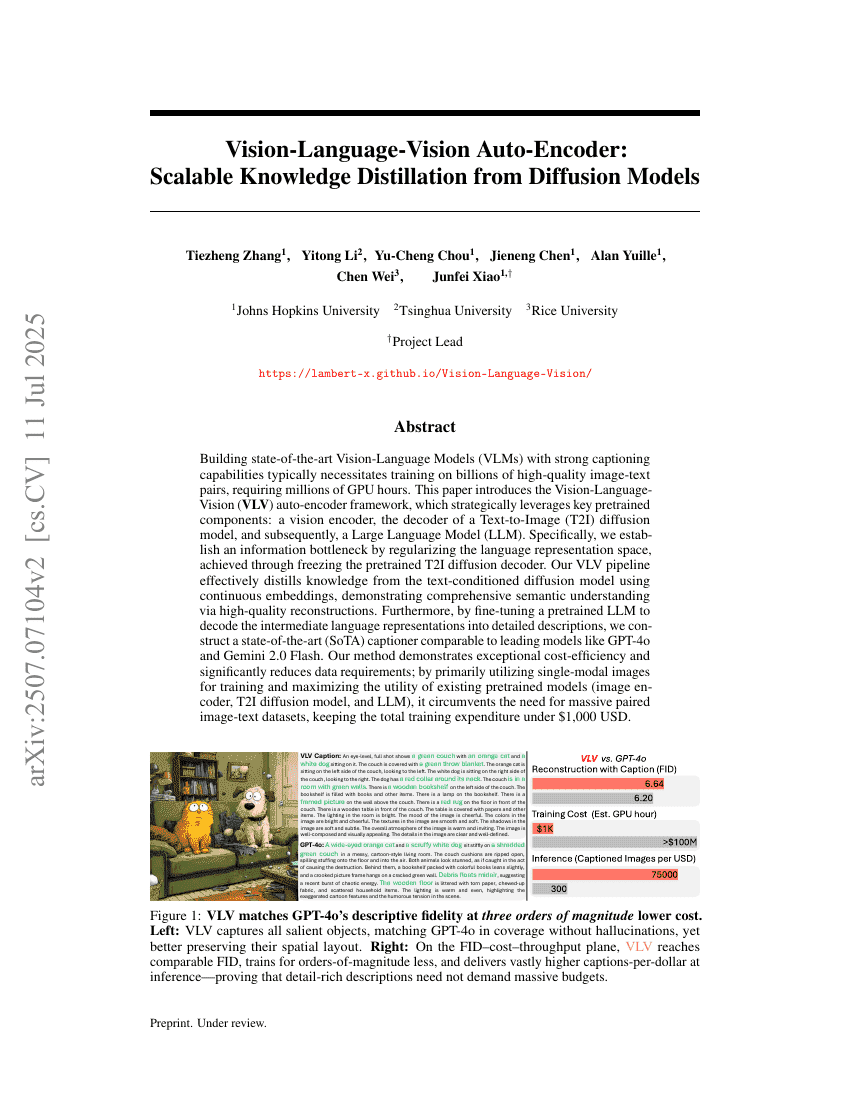

构建具有强大描述能力的最先进视觉-语言模型(VLMs)通常需要在数十亿个高质量的图像-文本对上进行训练,这需要数百万个GPU小时。本文介绍了一种视觉-语言-视觉(VLV)自动编码器框架,该框架战略性地利用了关键的预训练组件:一个视觉编码器、一个文本到图像(T2I)扩散模型的解码器,以及随后的一个大型语言模型(LLM)。具体而言,我们通过冻结预训练的T2I扩散解码器来建立一个信息瓶颈,从而对语言表示空间进行正则化。我们的VLV管道通过连续嵌入有效地从文本条件扩散模型中提取知识,并通过高质量的重建展示了全面的语义理解能力。此外,通过对预训练的LLM进行微调以将中间语言表示解码为详细描述,我们构建了一个与GPT-4o和Gemini 2.0 Flash等领先模型相当的最先进(SoTA)描述生成器。我们的方法展示了卓越的成本效益,并显著减少了数据需求;主要利用单模态图像进行训练,并最大化现有预训练模型(图像编码器、T2I扩散模型和LLM)的效用,从而避免了对大规模配对图像-文本数据集的需求,将总训练成本控制在1,000美元以内。