Command Palette

Search for a command to run...

摘要

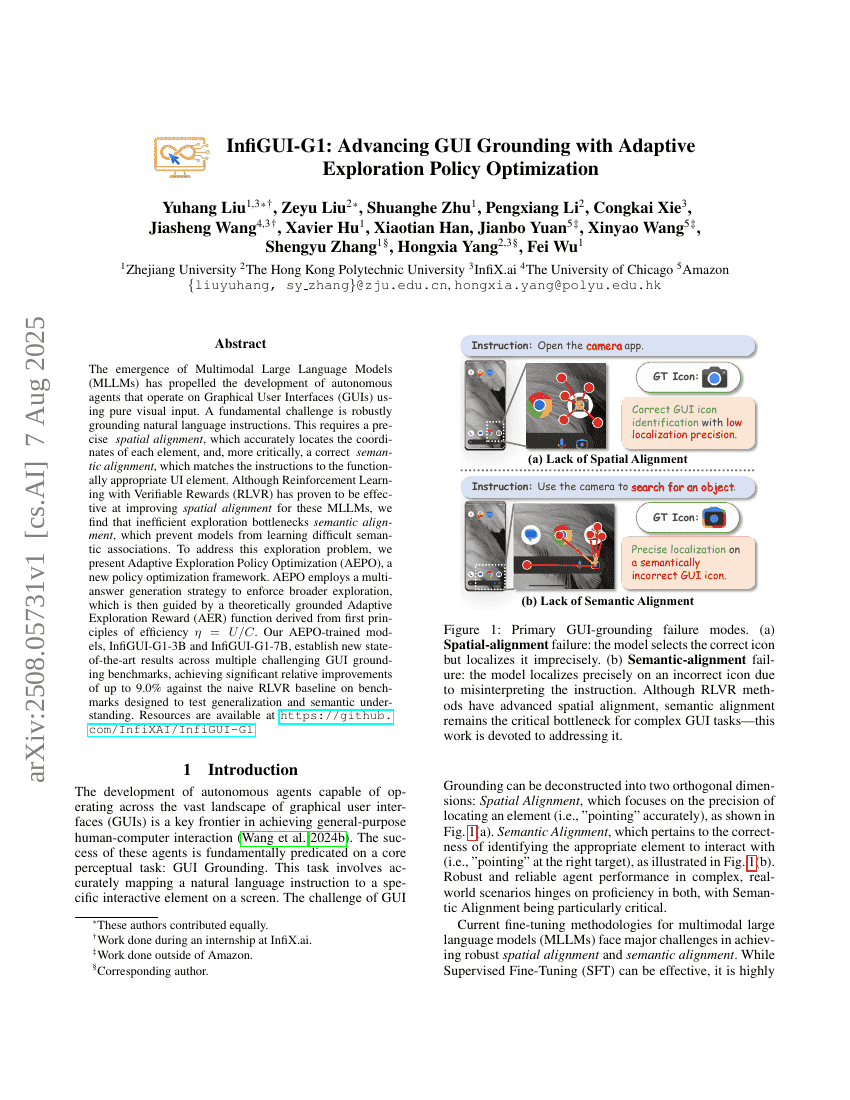

多模态大语言模型(Multimodal Large Language Models, MLLMs)的兴起,推动了基于纯视觉输入在图形用户界面(GUI)上运行的自主智能体的发展。一个核心挑战在于如何稳健地将自然语言指令与界面元素进行语义锚定。这不仅需要精确的空间对齐——准确识别每个界面元素的坐标位置,更关键的是语义对齐——将指令正确匹配到功能上合适的UI元素。尽管基于可验证奖励的强化学习(Reinforcement Learning with Verifiable Rewards, RLVR)已被证明能有效提升MLLMs在空间对齐方面的表现,但我们发现,低效的探索机制严重制约了语义对齐能力的提升,导致模型难以学习复杂的语义关联。为解决这一探索瓶颈问题,我们提出了一种新型策略优化框架——自适应探索策略优化(Adaptive Exploration Policy Optimization, AEPO)。AEPO采用多答案生成策略以促进更广泛的探索,并通过一个基于效率原理 η = U/C(即效用与成本之比)从第一性原理推导出的理论性自适应探索奖励函数(Adaptive Exploration Reward, AER)对探索过程进行引导。经AEPO训练的模型InfiGUI-G1-3B与InfiGUI-G1-7B,在多个具有挑战性的GUI锚定基准测试中取得了新的最先进性能,尤其在旨在评估泛化能力和语义理解的基准上,相较于朴素的RLVR基线,相对提升最高达9.0%。相关资源已开源,详见:https://github.com/InfiXAI/InfiGUI-G1。