Command Palette

Search for a command to run...

摘要

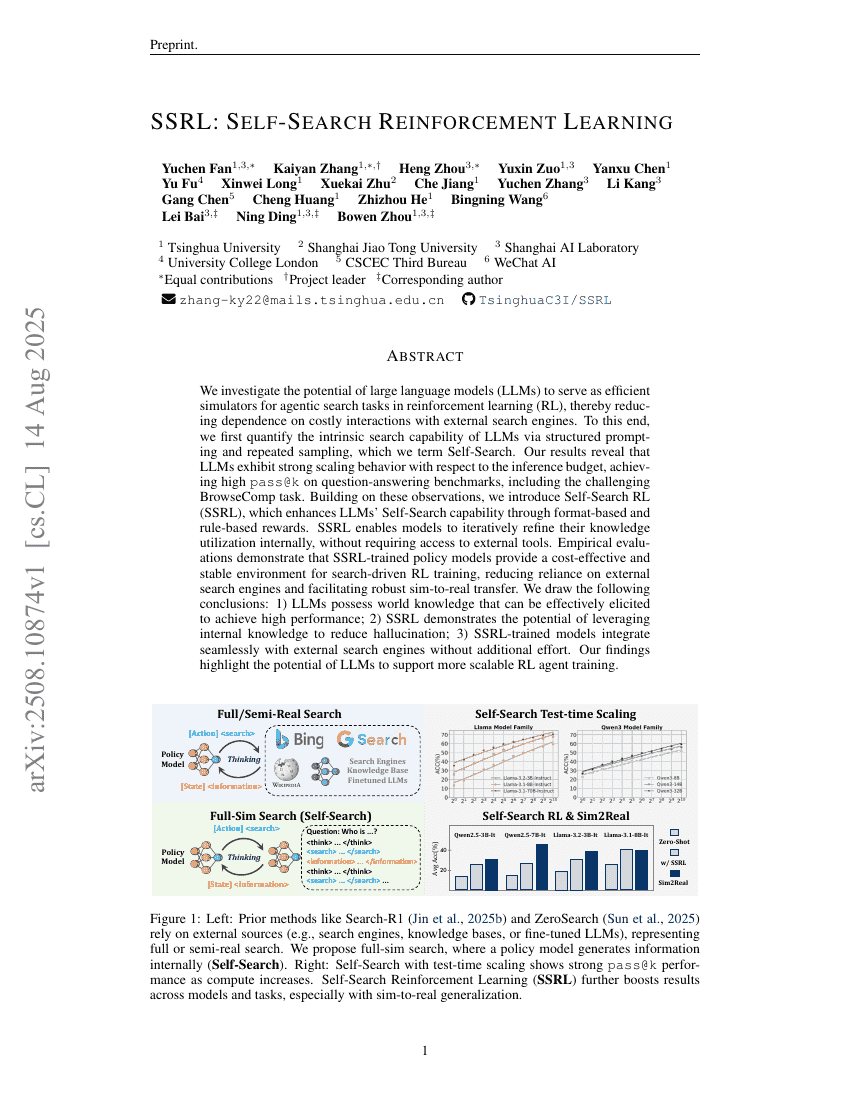

我们研究了大型语言模型(LLMs)作为强化学习(RL)中智能体搜索任务高效模拟器的潜力,从而降低对昂贵外部搜索引擎交互的依赖。为此,我们首先通过结构化提示(structured prompting)和重复采样,量化了LLMs固有的搜索能力,这一方法被称为Self-Search。实验结果表明,LLMs在推理预算增加时展现出显著的规模效应,在问答基准测试中,包括具有挑战性的BrowseComp任务,均取得了较高的pass@k指标。基于上述发现,我们提出了Self-Search RL(SSRL),通过基于格式和规则的奖励机制,进一步提升LLMs的Self-Search能力。SSRL使模型能够在不依赖外部工具的情况下,内部迭代地优化其知识利用策略。实证评估表明,经过SSRL训练的策略模型为搜索驱动的强化学习训练提供了一种成本低廉且稳定的环境,显著减少了对外部搜索引擎的依赖,并促进了从模拟到现实的鲁棒迁移。我们得出以下结论:1)LLMs具备可有效激发的世界知识,能够实现高性能表现;2)SSRL展示了利用内部知识以减少幻觉(hallucination)的潜力;3)SSRL训练后的模型可无缝集成外部搜索引擎,无需额外工作。我们的研究结果凸显了大型语言模型在支持更可扩展的强化学习智能体训练方面的巨大潜力。