Command Palette

Search for a command to run...

摘要

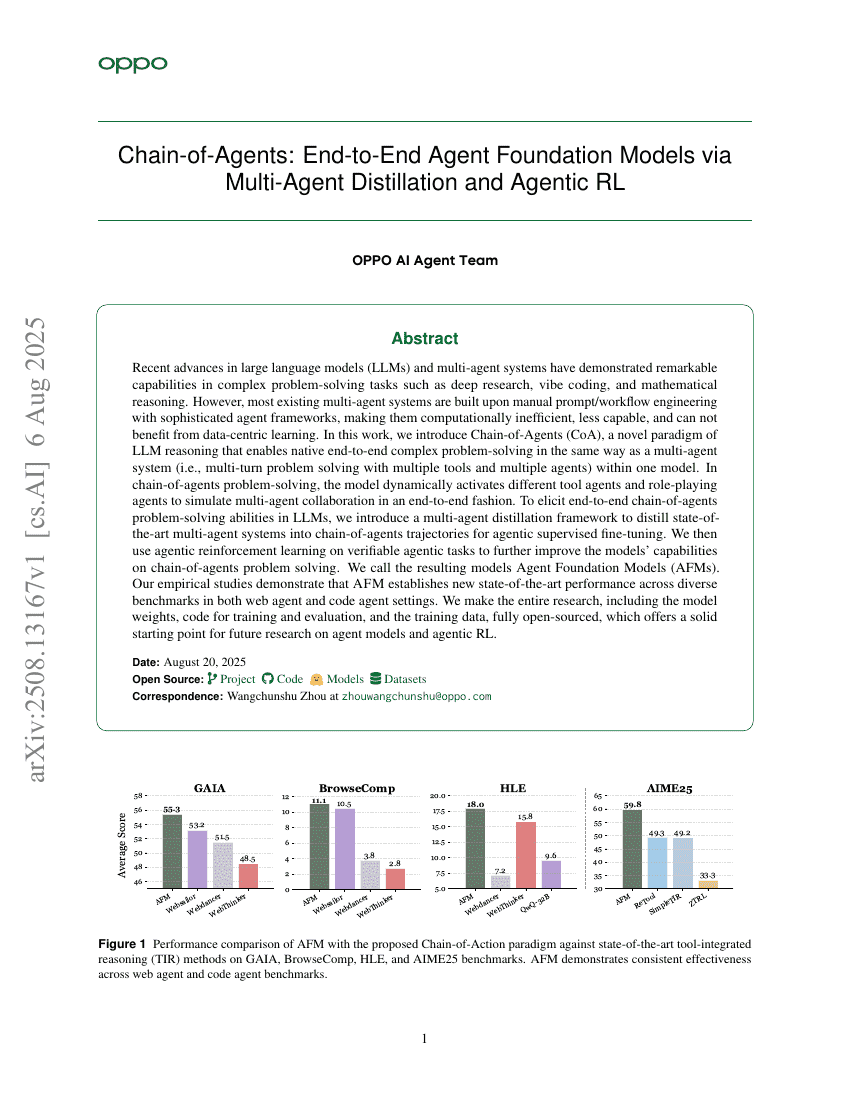

近年来,大型语言模型(LLMs)与多智能体系统在深度研究、氛围编程(vibe coding)以及数学推理等复杂问题求解任务中展现出卓越的能力。然而,现有的大多数多智能体系统依赖于人工设计的提示(prompt)或工作流工程,并构建在复杂的智能体框架之上,导致其计算效率低下、能力受限,且无法从以数据为中心的学习中获益。在本研究中,我们提出了智能体链(Chain-of-Agents, CoA)这一全新的LLM推理范式,该范式能够在单一模型内部原生地实现端到端的复杂问题求解,其机制与多智能体系统一致——即通过多轮交互、调用多种工具并协同多个智能体来完成任务。在智能体链的问题求解过程中,模型能够动态激活不同的工具型智能体与角色扮演型智能体,以端到端的方式模拟多智能体协作过程。为了激发大语言模型在端到端智能体链问题求解方面的能力,我们设计了一种多智能体蒸馏框架,将当前最先进的多智能体系统所生成的复杂行为轨迹,转化为智能体链的轨迹数据,用于智能体监督微调(agentic supervised fine-tuning)。随后,我们在可验证的智能体任务上引入智能体强化学习(agentic reinforcement learning),进一步提升模型在智能体链问题求解方面的性能。由此得到的模型我们称之为智能体基础模型(Agent Foundation Models, AFMs)。我们的实证研究表明,AFM在网页智能体与代码智能体等多种设置下,于多个基准测试中均取得了新的最先进性能。我们已将本研究的全部成果完全开源,包括模型权重、训练与评估代码,以及训练数据,为未来在智能体模型与智能体强化学习方向的研究提供了坚实可靠的基础。