Command Palette

Search for a command to run...

Yichao Fu Xuewei Wang Yuandong Tian Jiawei Zhao

摘要

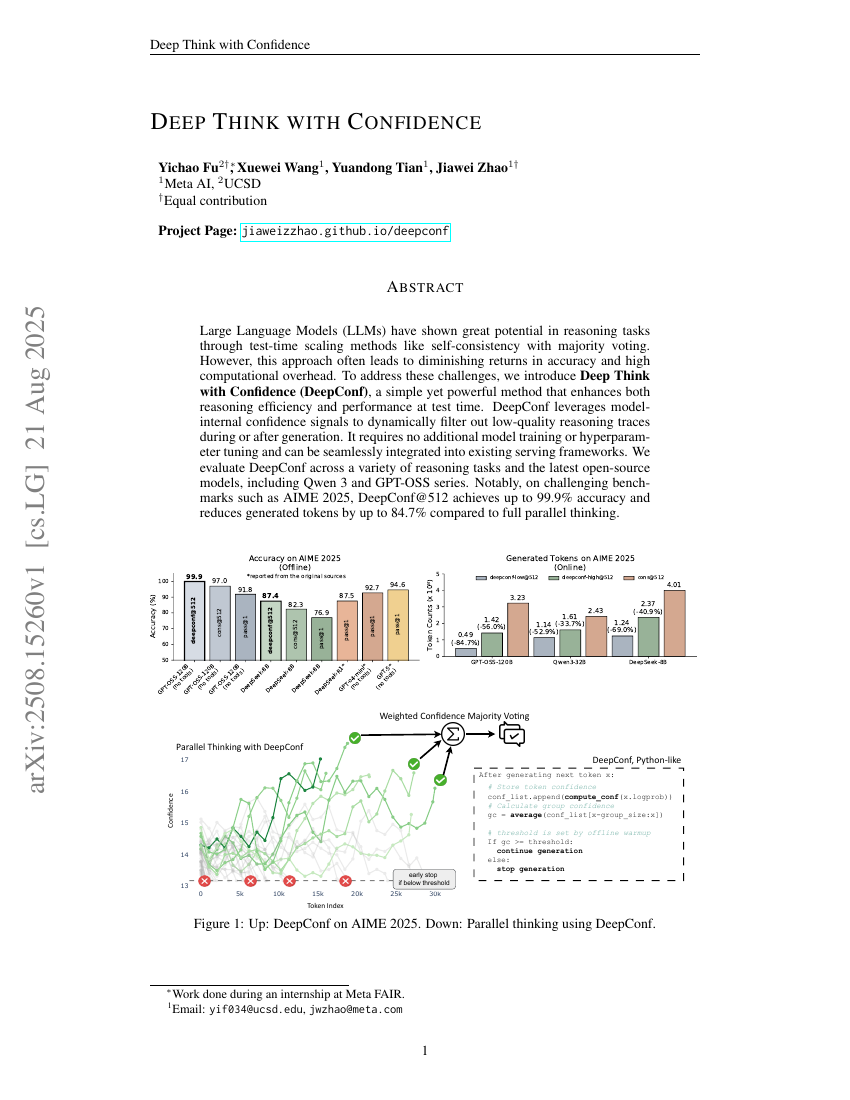

大型语言模型(LLMs)在推理任务中展现出巨大潜力,这主要得益于测试阶段扩展方法(如基于多数投票的自一致性)的应用。然而,这类方法往往导致准确率提升出现边际递减,且带来高昂的计算开销。为应对这些挑战,我们提出了一种简单而高效的方法——基于置信度的深度思考(Deep Think with Confidence,简称 DeepConf),该方法在测试阶段显著提升了推理效率与性能。DeepConf 利用模型内部的置信度信号,在生成过程中或生成后动态过滤低质量的推理路径。该方法无需额外的模型训练或超参数调优,可无缝集成至现有推理服务框架中。我们在多种推理任务及最新的开源模型(包括 Qwen 3 和 GPT-OSS 系列)上对 DeepConf 进行了评估。值得注意的是,在 AIME 2025 等具有挑战性的基准测试中,DeepConf@512 实现了高达 99.9% 的准确率,同时相比完整并行思维(full parallel thinking)方法,生成的 token 数量最多减少了 84.7%。