Command Palette

Search for a command to run...

Ji Xie Trevor Darrell Luke Zettlemoyer XuDong Wang

摘要

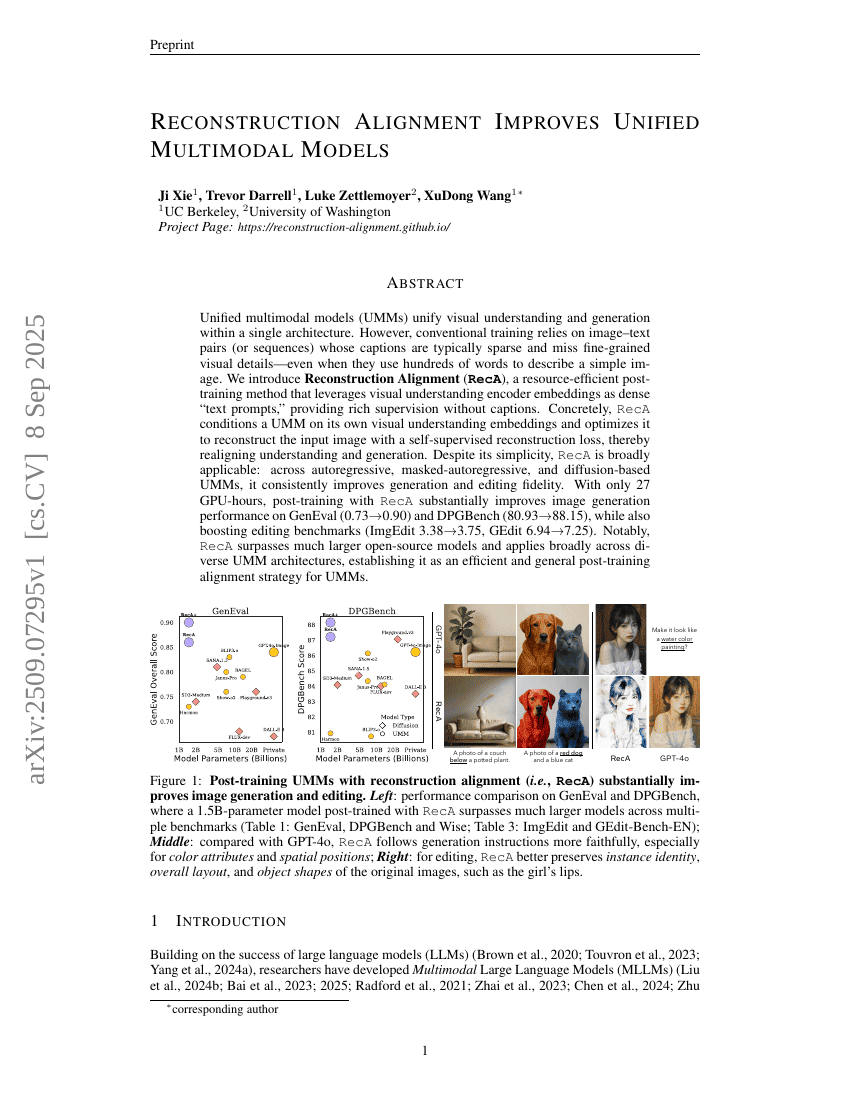

统一多模态模型(Unified Multimodal Models, UMMs)将视觉理解与生成能力整合于单一架构之中。然而,传统的训练方法依赖于图像-文本对(或序列),其描述通常较为稀疏,难以捕捉精细的视觉细节——即使使用数百个词描述一张简单的图像也是如此。为此,我们提出一种资源高效的后训练方法——重建对齐(Reconstruction Alignment, RecA),该方法利用视觉理解编码器的嵌入向量作为密集的“文本提示”,在无需标注文本的情况下提供丰富的监督信号。具体而言,RecA以模型自身的视觉理解嵌入为条件,通过自监督重建损失优化模型,使其重建输入图像,从而实现理解与生成能力的重新对齐。尽管方法简洁,RecA具有广泛的适用性:在自回归、掩码自回归以及基于扩散模型的各类UMM中,均能一致提升生成与编辑的保真度。仅需27个GPU小时的后训练,RecA便显著提升了GenEval(从0.73提升至0.90)和DPGBench(从80.93提升至88.15)上的图像生成性能,同时在图像编辑基准测试中也取得明显进步(ImgEdit从3.38提升至3.75,GEdit从6.94提升至7.25)。值得注意的是,RecA的表现超越了许多参数量更大的开源模型,并适用于多种多样的UMM架构,展现出高效且通用的后训练对齐潜力,为统一多模态模型的发展提供了一种强有力的新策略。