Command Palette

Search for a command to run...

摘要

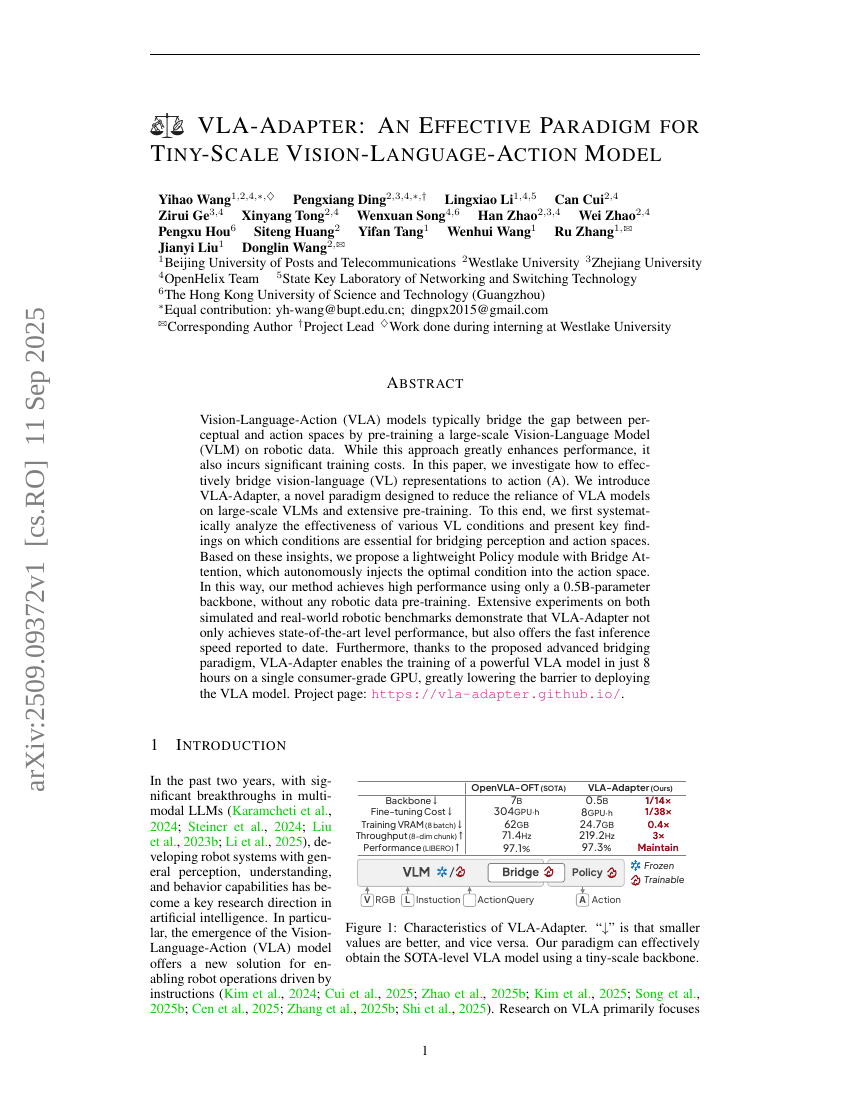

视觉-语言-动作(Vision-Language-Action, VLA)模型通常通过在机器人数据上预训练大规模视觉-语言模型(Vision-Language Model, VLM),来弥合感知空间与动作空间之间的鸿沟。尽管该方法显著提升了模型性能,但也带来了高昂的训练成本。本文研究了如何高效地将视觉-语言(VL)表征与动作(A)空间进行衔接。为此,我们提出了一种名为VLA-Adapter的新范式,旨在降低VLA模型对大规模VLM及大量预训练数据的依赖。为此,我们首先系统性地分析了多种视觉-语言条件的有效性,并揭示了在连接感知与动作空间过程中至关重要的关键条件。基于这些发现,我们设计了一种轻量级策略模块——桥接注意力(Bridge Attention),可自主地将最优条件注入动作空间。由此,我们的方法仅需一个0.5B参数的主干网络,且无需任何机器人数据的预训练,即可实现高性能表现。在模拟与真实世界机器人基准测试中的大量实验表明,VLA-Adapter不仅达到了当前最先进的性能水平,还实现了迄今为止最快的推理速度。此外,得益于所提出的先进桥接机制,VLA-Adapter仅需在单张消费级GPU上训练8小时,即可构建出强大的VLA模型,极大降低了VLA模型部署的技术门槛。项目主页:https://vla-adapter.github.io/。