Command Palette

Search for a command to run...

摘要

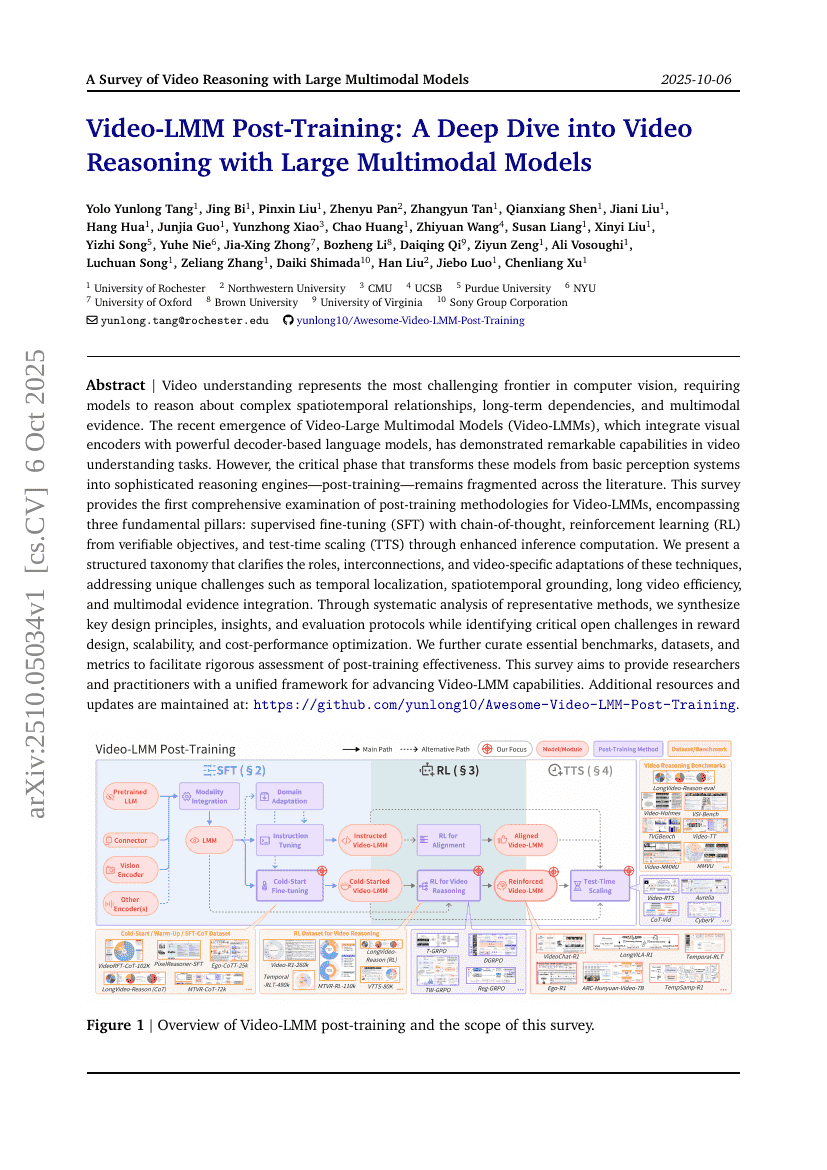

视频理解是计算机视觉领域最具挑战性的前沿方向,要求模型能够推理复杂的时空关系、长时依赖性以及多模态证据。近年来,视频大规模多模态模型(Video-Large Multimodal Models, Video-LMMs)的出现,通过将视觉编码器与强大的基于解码器的语言模型相结合,在视频理解任务中展现出卓越的能力。然而,将这些模型从基础感知系统转化为复杂推理引擎的关键阶段——后训练(post-training)——在现有文献中仍处于零散、缺乏系统梳理的状态。本综述首次对Video-LMMs的后训练方法进行了全面深入的分析,涵盖三大核心支柱:基于思维链(chain-of-thought)的监督微调(Supervised Fine-Tuning, SFT)、基于可验证目标的强化学习(Reinforcement Learning, RL),以及通过增强推理计算实现的测试时扩展(Test-Time Scaling, TTS)。我们构建了一个结构化的分类体系,清晰阐明了这些技术的角色定位、相互关联及其在视频任务中的特定适配策略,重点应对诸如时间定位、时空定位、长视频处理效率以及多模态证据融合等独特挑战。通过对代表性方法的系统性分析,我们总结出关键的设计原则、核心洞见与评估规范,同时指出了当前在奖励函数设计、可扩展性以及成本-性能优化方面存在的关键开放性问题。此外,我们还整理了若干核心基准测试、数据集与评估指标,以支持对后训练效果的严谨评估。本综述旨在为研究人员与实践者提供一个统一的框架,推动Video-LMM能力的持续提升。更多补充资源与最新动态请访问:https://github.com/yunlong10/Awesome-Video-LMM-Post-Training