Command Palette

Search for a command to run...

Hongliang Lu Yuhang Wen Pengyu Cheng Ruijin Ding Haotian Xu Jiaqi Guo Chutian Wang Haonan Chen Xiaoxi Jiang Guanjun Jiang

摘要

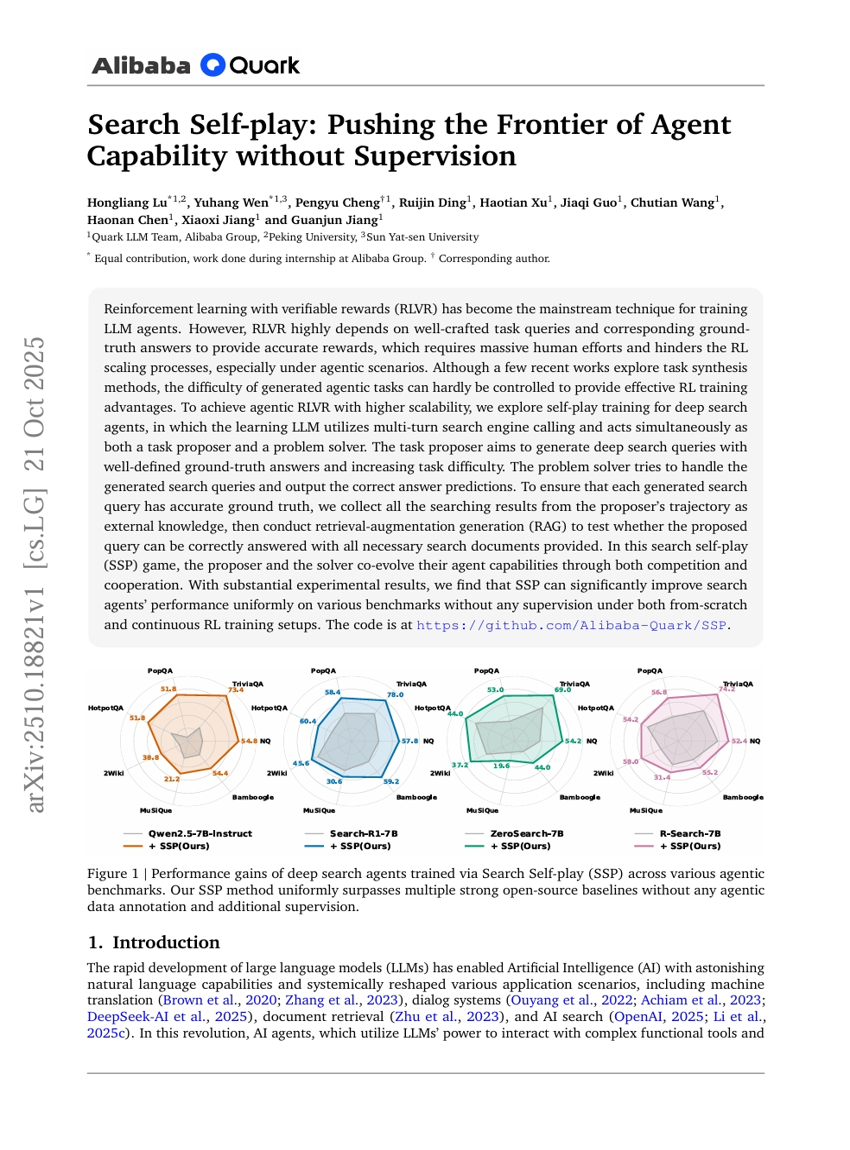

基于可验证奖励的强化学习(Reinforcement Learning with Verifiable Rewards, RLVR)已成为训练大语言模型智能体(LLM agents)的主流技术。然而,RLVR高度依赖精心设计的任务查询及其对应的正确答案以提供精确奖励,这需要大量人工投入,严重制约了强化学习在规模化训练中的扩展能力,尤其是在智能体(agentic)应用场景下。尽管近期已有少数研究探索任务合成方法,但所生成的智能体任务难度难以有效控制,难以为强化学习训练带来切实优势。为实现更具可扩展性的智能体RLVR,本文提出一种面向深度搜索智能体的自对弈(self-play)训练范式,其中学习型大语言模型通过多轮调用搜索引擎,同时扮演任务提出者与问题求解者的双重角色。任务提出者旨在生成具有明确定义正确答案且难度逐步提升的深度搜索查询;问题求解者则尝试处理这些生成的查询,并输出正确的答案预测。为确保每个生成的搜索查询均具备准确的“真实答案”,我们收集任务提出者在其行为轨迹中获取的所有搜索结果作为外部知识,进而采用检索增强生成(Retrieval-Augmented Generation, RAG)方法,验证在提供全部必要搜索文档的前提下,该查询是否能够被正确回答。在这一搜索自对弈(Search Self-Play, SSP)机制中,任务提出者与问题求解者通过竞争与协作的双重机制,共同演化其智能体能力。大量实验结果表明,无论是在从零开始(from-scratch)还是持续强化学习(continuous RL)训练设置下,SSP均能在无需任何监督信号的情况下,显著且一致地提升搜索智能体在多种基准测试上的性能。