Command Palette

Search for a command to run...

Jian Yang Wei Zhang Shark Liu Jiajun Wu Shawn Guo Yizhi Li

摘要

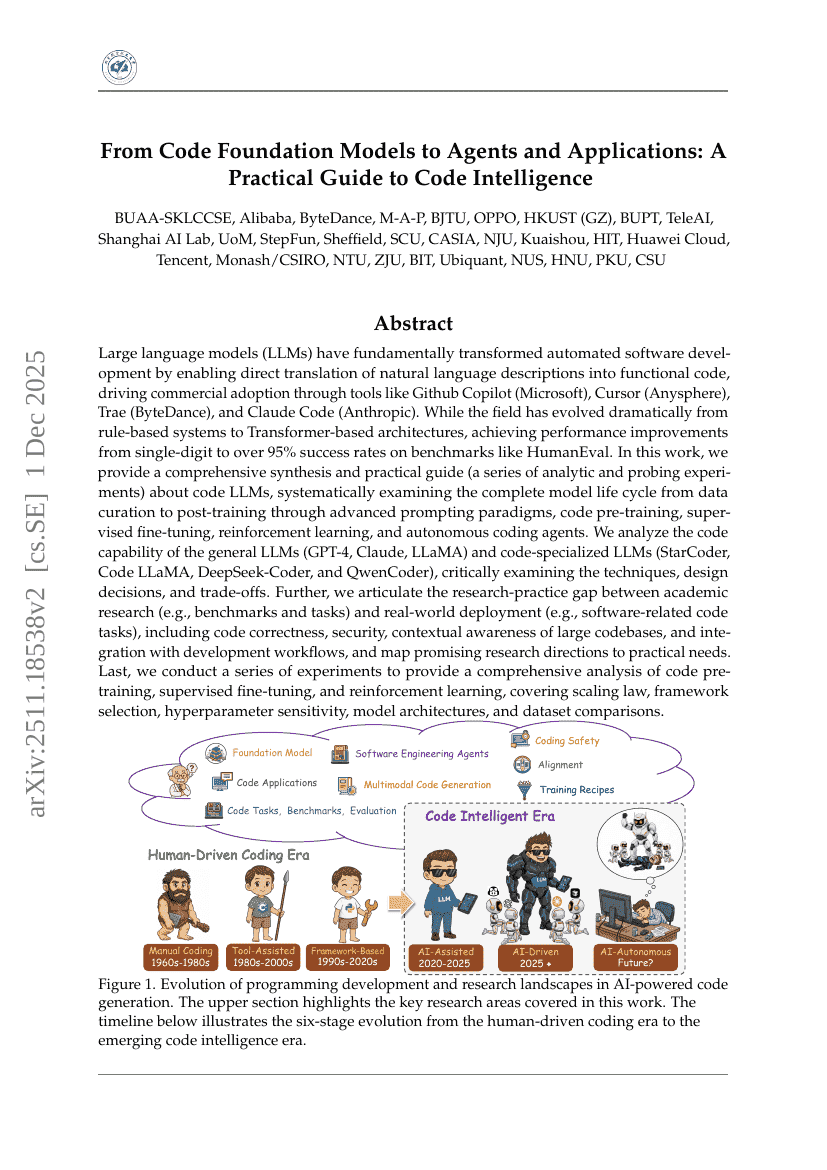

大规模语言模型(LLMs)通过实现自然语言描述到功能性代码的直接转换,从根本上重塑了自动化软件开发的范式。这一技术进步推动了商业应用的广泛落地,代表性工具包括 GitHub Copilot(微软)、Cursor(Anysphere)、Trae(字节跳动)以及 Claude Code(Anthropic)。尽管该领域已从早期的规则系统演进至基于 Transformer 的架构,其在 HumanEval 等基准测试上的任务成功率也从个位数跃升至超过 95%,但其发展仍处于持续深化阶段。在本研究中,我们系统性地整合并提供了一套全面的综合分析与实践指南(包含一系列分析性与探测性实验),深入探讨代码类 LLM 的完整生命周期,涵盖数据构建、预训练、提示工程(prompting)范式、代码预训练、监督微调、强化学习,以及自主编程代理的构建。我们对通用大语言模型(如 GPT-4、Claude、LLaMA)与代码专用大语言模型(如 StarCoder、Code LLaMA、DeepSeek-Coder 和 QwenCoder)的代码生成能力进行了全面评估,深入剖析各类技术路径、设计选择及其内在权衡。此外,我们明确指出了学术研究与实际部署之间的关键差距:学术研究多聚焦于标准化基准与任务设计,而真实软件开发场景则更关注代码正确性、安全性、对大型代码库的上下文理解能力,以及与现有开发工作流的无缝集成。基于此,我们进一步将前沿研究方向与实际工程需求进行映射,为未来研究提供切实可行的指导。最后,我们开展了一系列系统性实验,对代码预训练、监督微调与强化学习三大关键阶段进行全面分析,覆盖缩放定律(scaling laws)、框架选型、超参数敏感性、模型架构对比以及数据集差异等核心维度,为代码 LLM 的优化与部署提供可复现、可量化的实证依据。