Command Palette

Search for a command to run...

Zhennan Chen Junwei Zhu Xu Chen Jiangning Zhang Xiaobin Hu Hanzhen Zhao Chengjie Wang Jian Yang Ying Tai

摘要

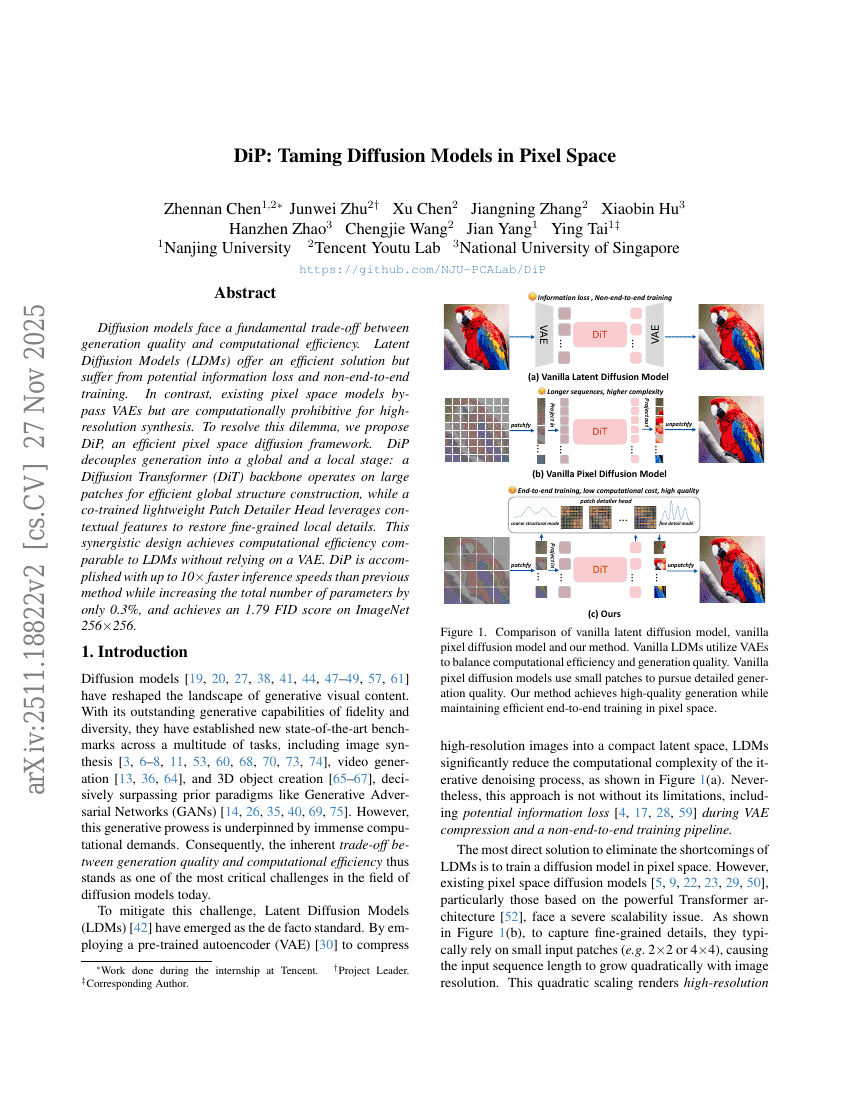

扩散模型在生成质量与计算效率之间面临根本性权衡。潜在扩散模型(Latent Diffusion Models, LDMs)虽能提供高效的解决方案,但存在潜在的信息丢失以及非端到端训练的问题。相比之下,现有的像素空间模型虽避免了变分自编码器(VAE)的使用,但在高分辨率图像生成任务中计算成本过高,难以实用。为解决这一困境,我们提出DiP——一种高效的像素空间扩散框架。DiP将生成过程解耦为全局与局部两个阶段:基于扩散Transformer(Diffusion Transformer, DiT)的主干网络在大图像块上运行,高效构建全局结构;同时,一个协同训练的轻量级局部细节恢复头(Patch Detailer Head)利用上下文特征,精准还原细粒度的局部细节。该协同设计在不依赖VAE的前提下,实现了与LDM相当的计算效率。DiP在推理速度上相比先前方法最快提升达10倍,同时模型总参数量仅增加0.3%,并在ImageNet 256×256数据集上取得了1.90的FID分数,显著提升了生成质量与效率的平衡。