Command Palette

Search for a command to run...

摘要

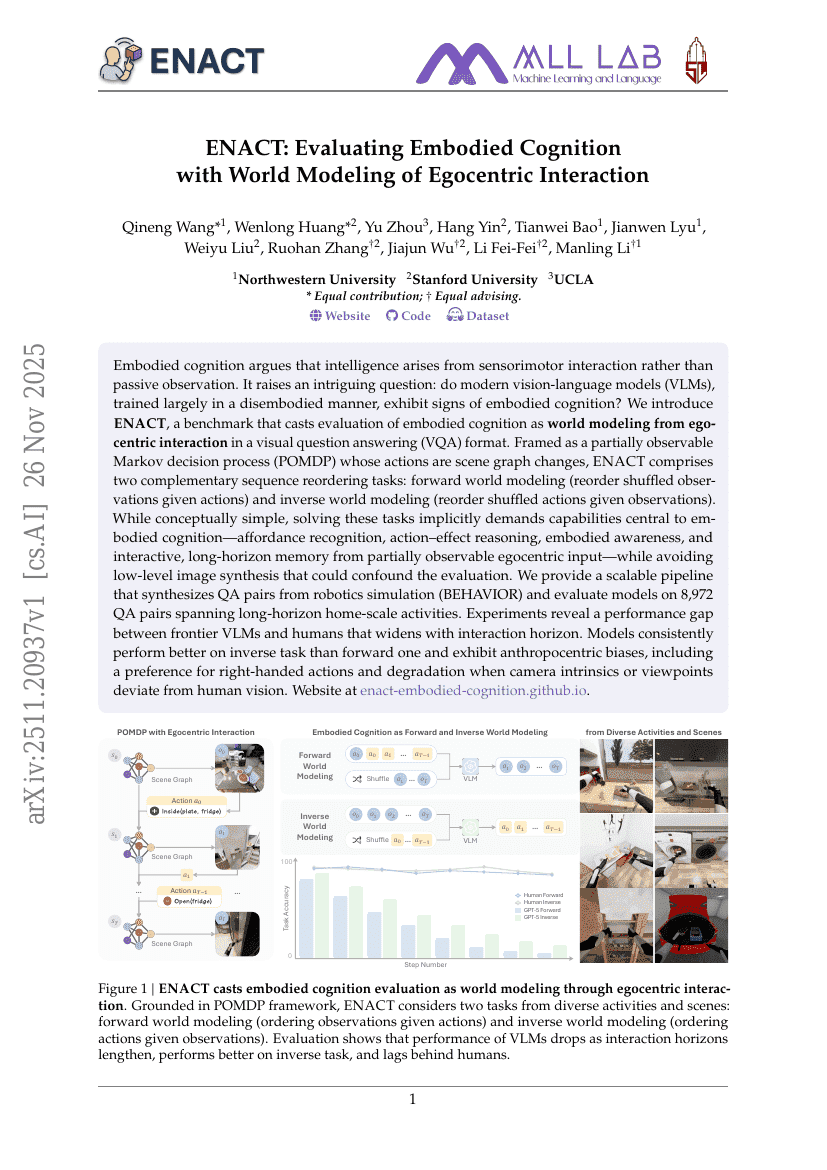

具身认知理论认为,智能源于感知-运动交互,而非被动观察。这一观点引出一个引人深思的问题:那些主要以非具身方式训练的现代视觉-语言模型(VLMs),是否展现出具身认知的迹象?为此,我们提出了ENACT——一个将具身认知评估转化为从第一人称视角交互中进行世界建模的基准测试框架,采用视觉问答(VQA)的形式呈现。ENACT将任务建模为一个部分可观测马尔可夫决策过程(POMDP),其中动作表现为场景图的变化,包含两个互补的序列重排序任务:正向世界建模(根据给定动作对打乱的观测序列进行重排序)与逆向世界建模(根据观测结果对打乱的动作序列进行重排序)。尽管概念上简洁明了,但解决这些任务隐含地要求模型具备具身认知的核心能力——包括对物体可用性的识别、动作-效果推理、具身意识,以及从部分可观测的第一人称输入中实现交互式、长时程的记忆,同时避免低层级图像生成,以免干扰评估结果的准确性。我们构建了一个可扩展的流水线,从机器人仿真数据集(BEHAVIOR)中合成问答对,并在涵盖长时程家庭场景活动的8,972组问答对上对模型进行评估。实验结果表明,前沿VLMs与人类在性能上存在显著差距,且该差距随交互时长的增加而扩大。模型在逆向任务上的表现始终优于正向任务,并表现出人类中心主义偏差,例如偏好右手动作,以及当相机内参或视角偏离人类视觉特征时性能明显下降。相关网站详见:https://enact-embodied-cognition.github.io/。