Command Palette

Search for a command to run...

摘要

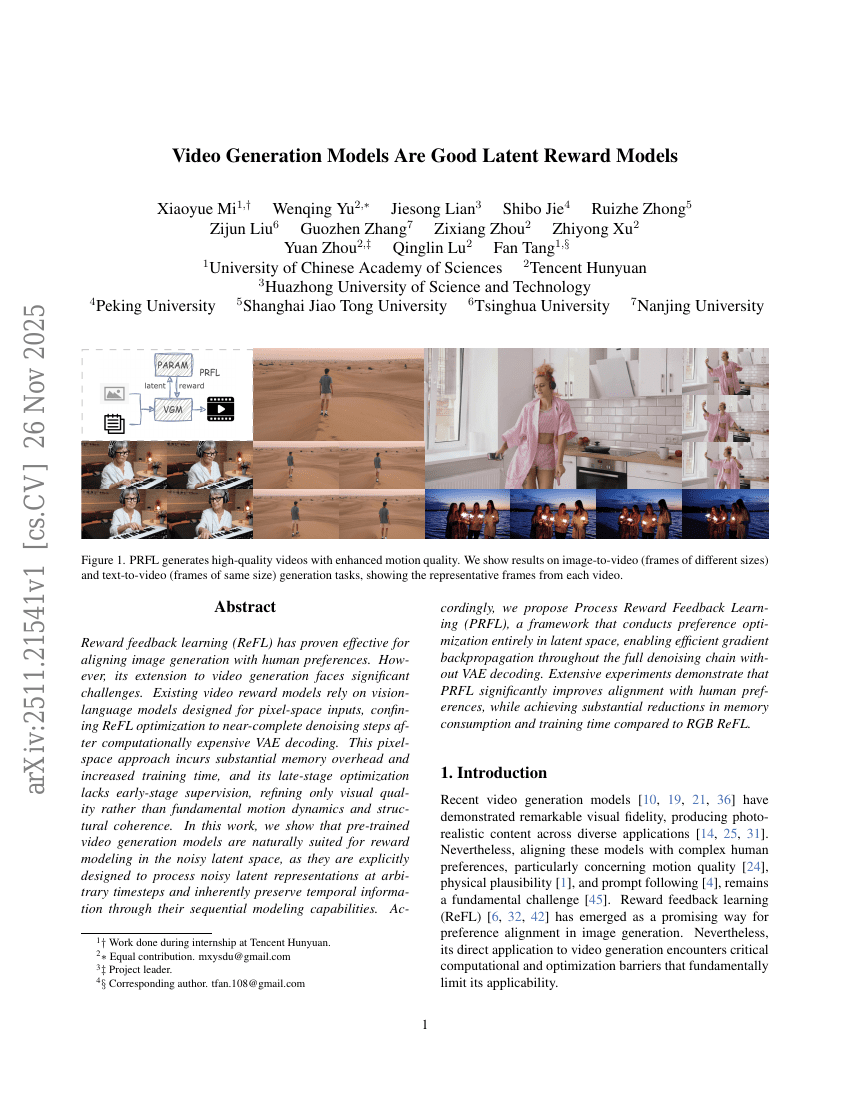

奖励反馈学习(Reward Feedback Learning, ReFL)在对齐图像生成与人类偏好方面已证明具有显著效果。然而,将其扩展至视频生成领域仍面临重大挑战。现有的视频奖励模型依赖于为像素空间输入设计的视觉-语言模型,导致ReFL优化被限制在计算成本高昂的VAE解码之后的近完全去噪阶段。这种基于像素空间的方法不仅带来巨大的内存开销和训练时间增加,而且由于仅在后期阶段进行优化,缺乏早期监督,仅能改善视觉质量,而无法有效建模运动动态和结构连贯性等核心视频特征。在本工作中,我们发现预训练的视频生成模型天然适用于在噪声潜空间中进行奖励建模。这类模型在设计上即具备处理任意时间步噪声潜变量表示的能力,并通过其序列建模机制自然地保留了时间信息。基于此,我们提出过程奖励反馈学习(Process Reward Feedback Learning, PRFL),一种完全在潜空间中进行偏好优化的框架。该方法无需VAE解码,即可实现全去噪链路中的高效梯度反向传播。大量实验表明,PRFL在显著提升生成内容与人类偏好对齐度的同时,相比基于RGB空间的ReFL,大幅降低了内存消耗和训练时间,展现出卓越的效率与性能优势。