Command Palette

Search for a command to run...

Yusuf Dalva Guocheng Gordon Qian Maya Goldenberg Tsai-Shien Chen Kfir Aberman Sergey Tulyakov Pinar Yanardag Kuan-Chieh Jackson Wang

摘要

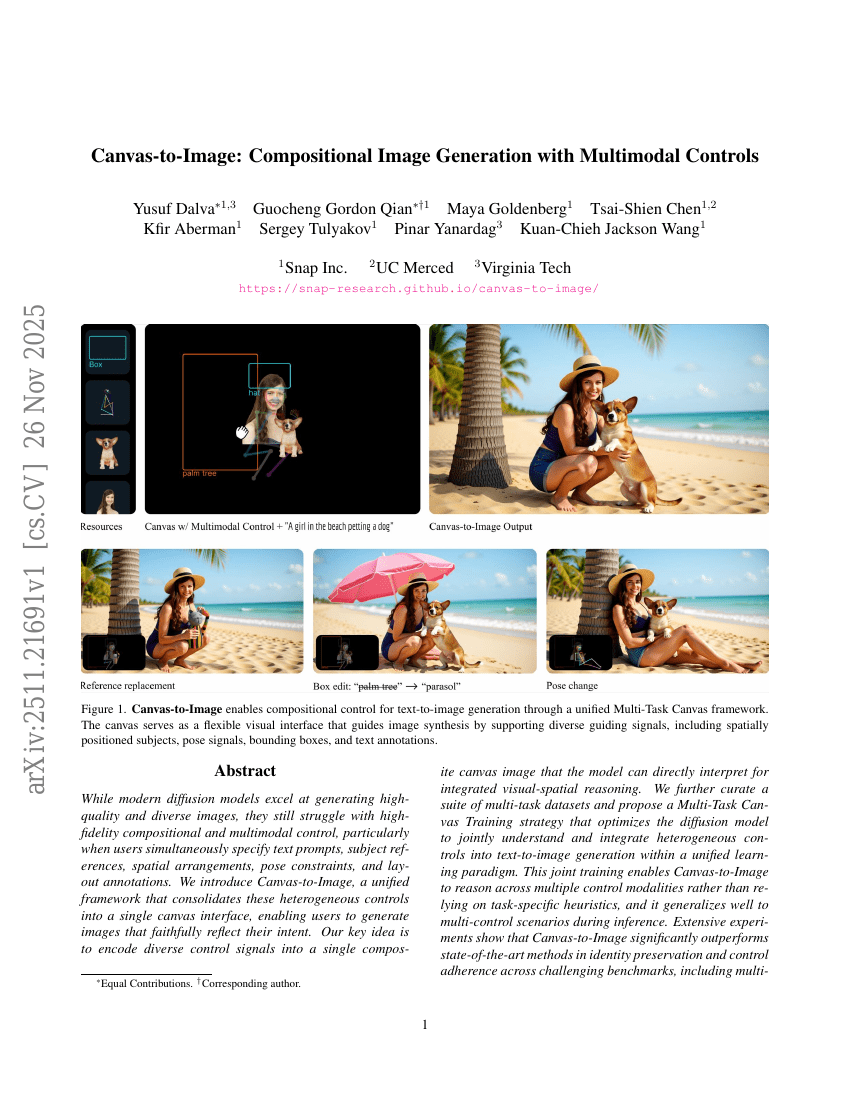

尽管现代扩散模型在生成高质量且多样化的图像方面表现出色,但在高保真度的构图控制与多模态协同控制方面仍面临挑战,尤其是在用户同时提供文本提示、主体参考、空间布局、姿态约束和版面标注等多种控制条件时。为此,我们提出了一种统一框架——Canvas-to-Image,该框架将这些异构控制信号整合至单一画布界面中,使用户能够生成准确反映其创作意图的图像。我们的核心思想是将多种控制信号编码为一张复合画布图像,供模型直接解析,从而实现集成化的视觉-空间推理。此外,我们构建了一套多任务数据集,并提出了一种多任务画布训练策略(Multi-Task Canvas Training),在统一的学习范式下优化扩散模型,使其能够联合理解并融合异构控制信号,完成文本到图像的生成任务。这种联合训练机制使Canvas-to-Image具备跨多模态控制信号进行推理的能力,而非依赖于特定任务的启发式规则,且在推理阶段对多控制场景具有良好的泛化性能。大量实验表明,Canvas-to-Image在多个具有挑战性的基准测试中,显著优于当前最先进的方法,在身份保持、控制遵循性等方面均展现出卓越表现,涵盖多人构图、姿态控制构图、布局约束生成以及多控制联合生成等多种复杂场景。