Command Palette

Search for a command to run...

摘要

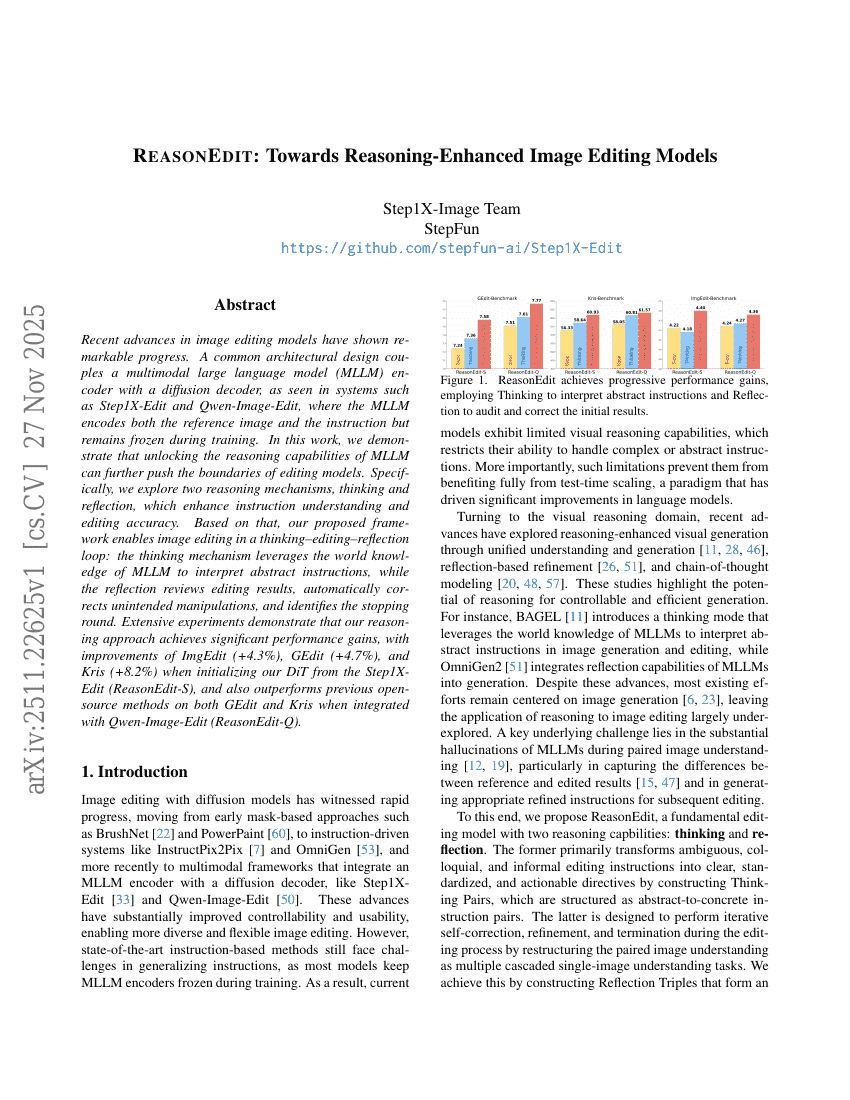

近年来,图像编辑模型取得了显著进展。一种常见的架构设计是将多模态大语言模型(MLLM)编码器与扩散解码器相结合,如Step1X-Edit和Qwen-Image-Edit等系统所示,其中MLLM同时编码参考图像和编辑指令,但在训练过程中保持冻结状态。在本工作中,我们证明了激活MLLM的推理能力,能够进一步推动图像编辑模型的性能边界。具体而言,我们探索了两种推理机制——“思考”(thinking)与“反思”(reflection),以提升对指令的理解能力与编辑的准确性。基于此,我们提出了一种“思考-编辑-反思”循环框架:其中,“思考”机制利用MLLM所具备的世界知识,解析抽象的编辑指令;而“反思”机制则对编辑结果进行评估,自动纠正意外的修改操作,并判断是否达到停止迭代的条件。大量实验表明,所提出的推理方法显著提升了模型性能——在以Step1X-Edit(ReasonEdit-S)的DiT模型为初始化基础时,ImgEdit、GEdit和Kris三项指标分别提升4.3%、4.7%和8.2%;当与Qwen-Image-Edit结合时,ReasonEdit-Q在GEdit和Kris两个基准上也优于此前所有开源方法。