Command Palette

Search for a command to run...

摘要

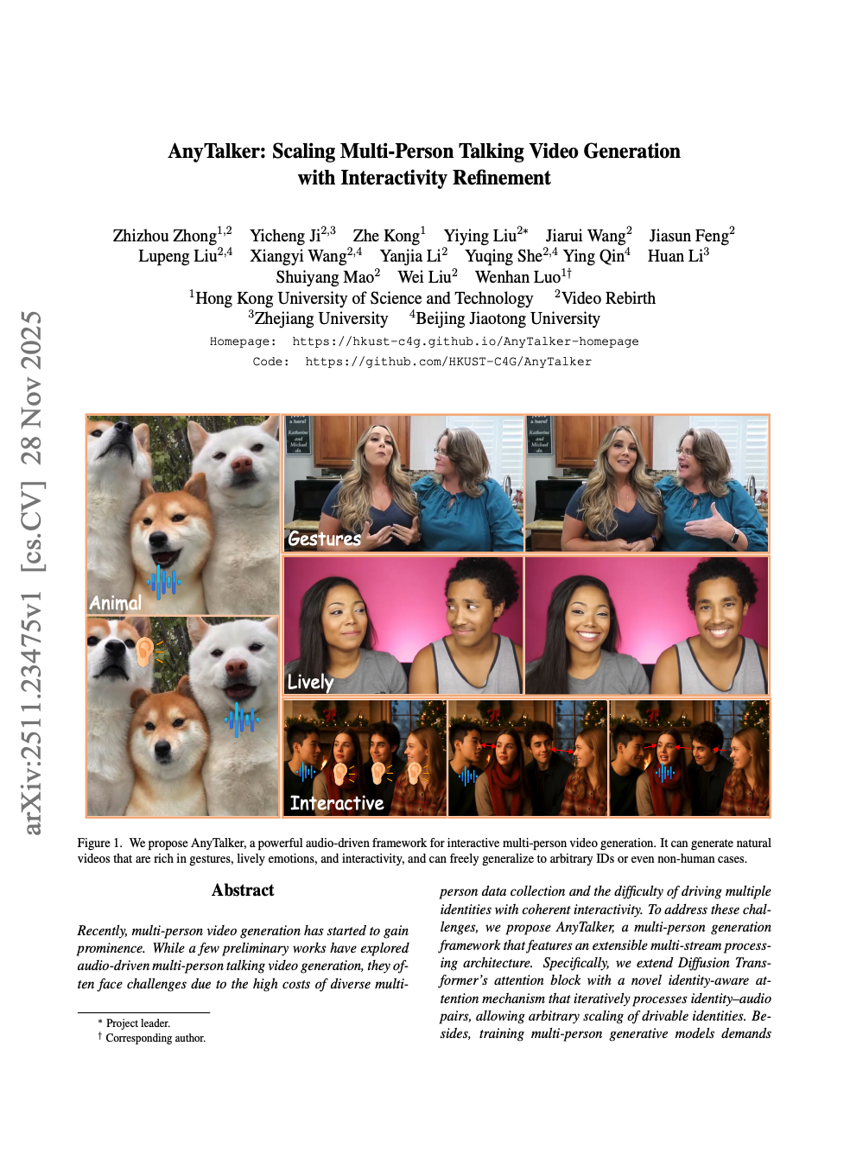

近年来,多人物视频生成开始受到广泛关注。尽管已有少数初步研究探索了基于音频驱动的多人物对话视频生成,但这类方法通常面临高昂的多人物数据采集成本,以及难以实现多个角色之间连贯互动的挑战。为应对这些难题,我们提出了一种名为AnyTalker的多人物生成框架,其核心为可扩展的多流处理架构。具体而言,我们对Diffusion Transformer的注意力模块进行了创新性扩展,引入了一种新型的身份感知注意力机制,能够迭代处理身份-音频配对,从而实现可任意扩展的可驱动角色数量。此外,训练多人物生成模型通常需要大量多人物数据,而我们的训练流程仅依赖单人物视频来学习多人物的说话模式,并仅需少量真实多人物视频片段即可优化角色间的互动性。同时,我们还构建了一个针对性的评估指标与数据集,用于衡量生成视频的自然度与角色间互动的流畅性。大量实验结果表明,AnyTalker在唇部同步、视觉质量以及自然互动性方面均表现出色,成功在数据成本与可扩展性之间取得了良好平衡。