Command Palette

Search for a command to run...

GR-Dexter 技术报告

GR-Dexter 技术报告

摘要

视觉-语言-动作(Vision-Language-Action, VLA)模型已实现基于语言指令的长时程机器人操作,但现有大多数系统仍局限于夹爪式机器人。将VLA策略扩展至具备高自由度(DoF)灵巧双手的双臂机器人,仍面临诸多挑战,包括动作空间的显著扩大、手-物之间频繁的遮挡,以及真实机器人数据采集成本高昂等问题。本文提出GR-Dexter,一个面向双臂灵巧手机器人的VLA基通用操作的完整硬件-模型-数据一体化框架。我们的方法融合了紧凑型21自由度机器人手的设计、面向真实机器人数据采集的直观双臂遥操作系统,以及一种创新的训练方案——该方案结合遥操作生成的机器人轨迹,以及大规模视觉-语言数据集与精心构建的跨体态数据集。在涵盖长时程日常操作与可泛化抓取-放置任务的真实世界评估中,GR-Dexter展现出优异的域内性能,并显著提升了对未见物体和未见指令的鲁棒性。我们期望GR-Dexter能为实现通用型灵巧手机器人操作迈出切实可行的一步。

一句话总结

作者提出 GR-Dexter,一个面向双臂灵巧手操作的综合性框架,采用 21-DoF 机器人手、直观的遥操作以及结合真实机器人轨迹与视觉-语言及跨体感数据的训练方法,实现了对未见物体和指令的鲁棒、语言驱动的长时程任务,显著提升了泛化能力。

主要贡献

- GR-Dexter 解决了将视觉-语言-动作(VLA)模型扩展至高自由度灵巧手双臂机器人所面临的挑战,这些挑战包括动作空间扩大、频繁的手-物体遮挡以及真实机器人数据采集成本高昂。

- 该框架引入了一款紧凑的 21-DoF 机器人手(ByteDexter V2)、基于 Meta Quest 和 Manus 手套的直观双臂遥操作系统,以及一种联合训练策略,同时利用遥操作机器人轨迹、视觉-语言数据、跨体感人类示范和人类手部运动视频进行训练。

- 在真实世界评估中,GR-Dexter 在长时程日常操作任务中表现出色,并展现出对未见物体和此前未见语言指令的更强鲁棒性,通过多样化数据源提升泛化能力,超越了域内场景的限制。

引言

视觉-语言-动作(VLA)模型已推动语言驱动的长时程机器人操作发展,但大多数系统仍局限于夹爪式末端执行器。将这些模型扩展至高自由度(DoF)灵巧手的双臂机器人极具挑战性,原因在于动作空间扩大、频繁的手-物体遮挡,以及真实机器人数据采集成本高昂。以往工作在复杂真实场景中面临数据稀缺和泛化能力差的问题。本文提出 GR-Dexter,一个综合性框架,整合了紧凑的 21-DoF 仿人机器人手(ByteDexter V2)、基于 VR 与手套追踪的直观双臂遥操作界面,以及结合遥操作机器人轨迹、视觉-语言数据、跨体感人类示范和精选的人类手-物体交互数据集的 VLA 训练方法。该方法实现了在真实世界长时程任务和未见场景中鲁棒、可泛化的灵巧操作,为通用灵巧手机器人提供了一条切实可行的路径。

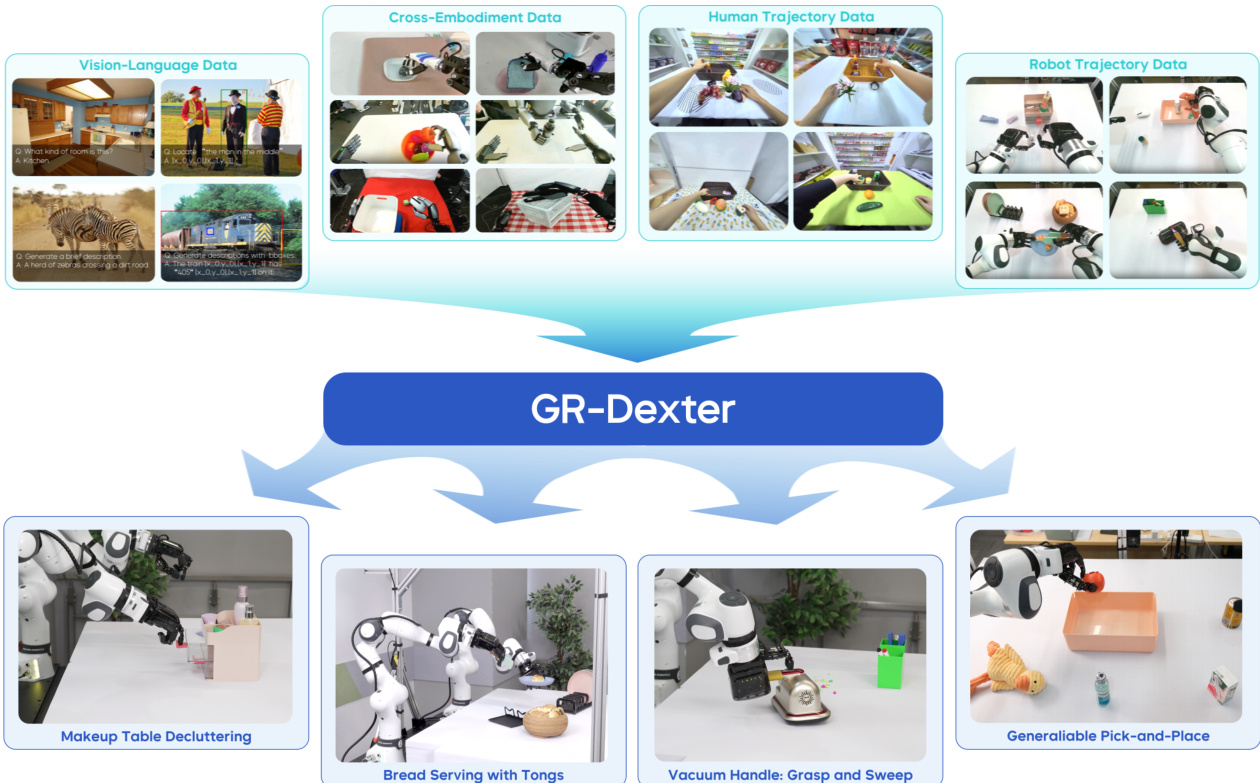

数据集

- GR-Dexter 的数据集由三大来源构成:网络规模的视觉-语言数据、跨体感真实机器人轨迹,以及通过 VR 设备收集的人类轨迹数据。

- 视觉-语言数据复用自 GR-3,包含图像描述、视觉问答和基于场景的图像描述等任务,构成大规模语料库,用于通过下一项预测训练 VLM 主干网络。

- 真实机器人数据来自三个开源双臂操作数据集:Fourier ActionNet(140 小时人形双臂操作,配备 6-DoF 手部)、OpenLoong Baihu(超过 10 万条轨迹,涵盖多种机器人形态)和 RoboMIND(107k 条轨迹,覆盖 479 项任务,涉及 96 类物体)。

- 人类轨迹数据包含超过 800 小时的视角内视频,配有 3D 手指与手部追踪,使用 Pico VR 设备采集,并通过额外的 VR 记录补充以增强多样性和规模。

- 为应对各数据集间的结构差异,预处理阶段会屏蔽缺失或不可靠的动作维度(如目标形态中缺失的关节)。

- 所有视觉输入均通过缩放和裁剪标准化,确保机器人手臂、手部和物体在各数据集间尺度一致。

- 经过严格质量控制后,仅保留高质量轨迹,使用干净、稳定的序列进行训练。

- 跨体感轨迹通过指尖中心对齐方式重定向至 ByteDexter V2 手部,保留任务相关的接触几何结构,同时对关节级差异具有鲁棒性。

- 人类轨迹根据手部可见性和运动速度进行过滤,以减少视角运动和时间抖动带来的噪声。随后通过相同的重定向流程映射至与机器人数据一致的视觉与运动空间。

- 轨迹按任务类别重采样,以平衡训练语料库,确保各类操作任务的均衡表示。

- 训练过程中,作者在小批量中动态混合视觉-语言数据与机器人轨迹,将下一项预测损失(用于 VLM 主干)与流匹配损失(用于动作 DiT)结合为联合训练目标。

- 统一的预处理流程确保所有数据类型无缝集成,支持 VLM 与动作模型在多样化、高质量且均衡数据集上的有效联合训练。

方法

作者采用模块化且仿生的设计构建 ByteDexter V2 机器人手,其采用连杆驱动传动机制,提升力透明度、耐用性和可维护性。该手共 21 个自由度(DoFs),四指每指 4 个 DoF,拇指 5 个 DoF,可实现广泛的对向运动。四指采用模块化架构,每指在掌指关节(MCP)处配备万向节,近端指间关节(PIP)和远端指间关节(DIP)各设两个旋转关节。MCP 关节由掌心内两个电机驱动,实现外展-内收与屈伸运动;PIP 关节由独立的第三电机驱动,与 MCP 运动解耦。拇指在腕掌关节(CMC)处采用万向节,并增加一个旋转关节,以模拟人手鞍形 CMC 关节,实现屈伸与外展-内收运动。该设计扩大了拇指的运动范围和可达工作空间,促进与其他手指的稳健对向接触。四指的 DIP 关节和拇指的指间(IP)关节为欠驱动设计,采用仿生四连杆机构,将每个 DIP 与其对应的 PIP 耦合,复现人手中的内在运动耦合特性。指尖配备高密度压阻式触觉阵列,可测量法向接触力,在指尖、指腹和侧表面提供精细的空间分辨率。

双臂机器人系统将两个 ByteDexter V2 手安装于 Franka Research 3 机械臂上,构成一个 56-DoF 机器人,支持协调的臂-手控制以实现灵巧操作。为从多视角捕捉手-物体交互并缓解遮挡问题,系统部署了四台全局 RGB-D 相机:一台主视角内视图和三台辅助第三人称视角。该平台支持遥操作数据采集与自主策略回放。遥操作采用双臂界面,结合 Meta Quest VR 头显(用于腕部姿态追踪)、Manus Metagloves(用于手部动作捕捉)以及脚踏板(用于启用/禁用遥操作)。两个 Meta Quest 控制器安装在手套背侧,以提升腕-手追踪可靠性。人类动作通过全身控制器实时重定向为关节位置指令,确保运动学一致映射。手部动作重定向被建模为带约束的优化问题,包含腕部到指尖、拇指到指尖对齐项、避碰约束和正则化项,使用序列二次规划(SQP)求解。在策略回放阶段,模型生成未来动作块,促进协调且时间一致的臂-手运动,以实现灵巧操作。参数化轨迹优化器对生成动作进行平滑处理,确保块内与块间过渡平滑,这对精细抓取至关重要。

GR-Dexter 模型沿用 GR-3 架构,采用 Transformer 混合框架构建视觉-语言-动作(VLA)模型 πθ,参数量达 40 亿。该模型根据输入语言指令 l、观测 ot 和机器人状态 st,生成长度为 k 的动作块 at=at:t+k。每个动作 at 为长度 88 的向量,包含:1)臂部关节动作(每臂 7 个 DoF),2)臂部末端执行器位姿(每臂 6D),3)手部关节动作(每手 16 个活跃 DoF),4)指尖位置(每指 3D)。模型在多样化数据集上训练,包括视觉-语言数据、人类轨迹数据和机器人轨迹数据,如框架图所示。训练过程利用跨体感数据,使模型能够泛化至不同任务与环境,如梳妆台整理、用夹子分发面包、真空吸持,以及通用的拾取-放置操作。

实验

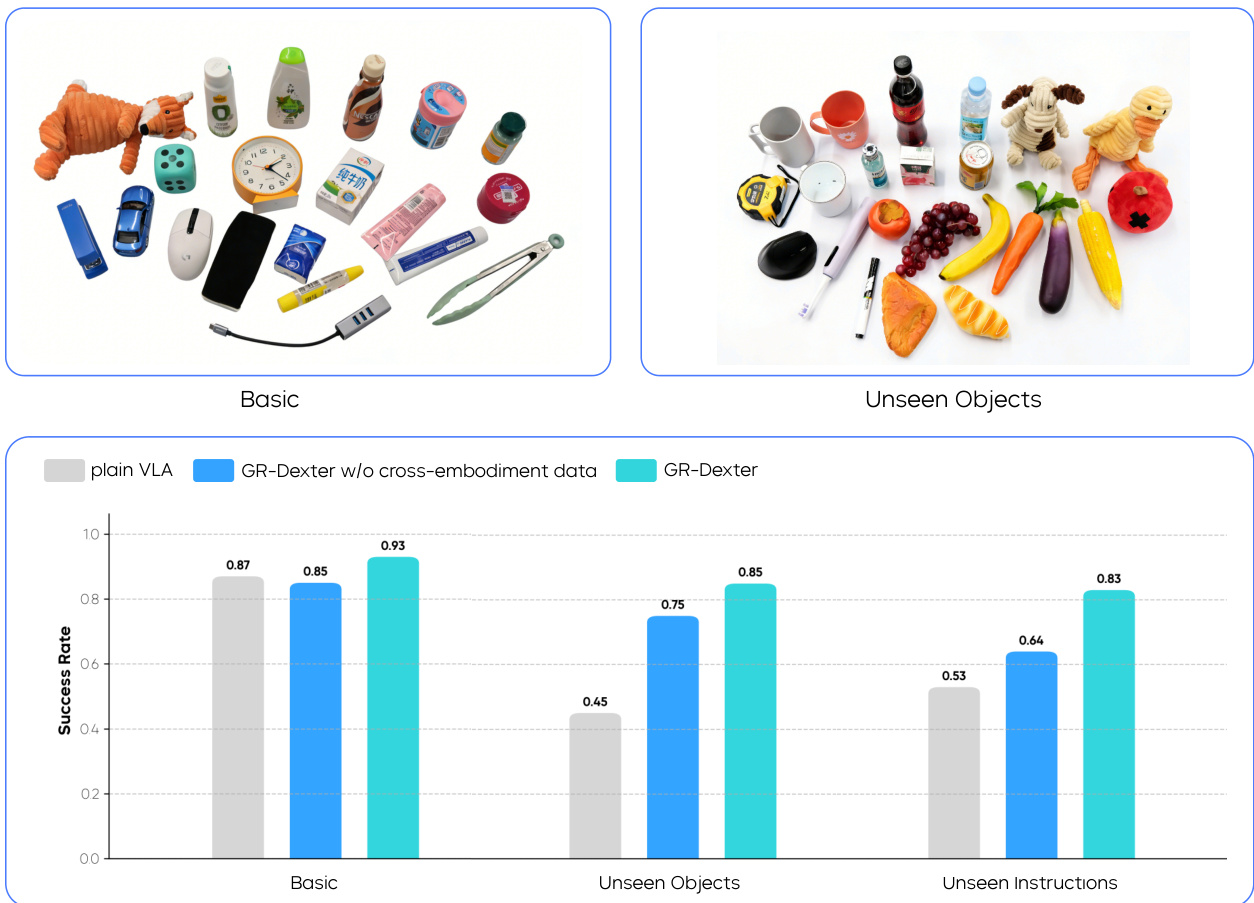

- 在 21-DoF ByteDexter V2 手与 20 小时遥操作机器人轨迹基础上,评估 GR-Dexter 在长时程双臂操作与可泛化拾取-放置任务上的表现。

- 在梳妆台整理任务中,GR-Dexter 在分布外(OOD)设置下对新布局的完成率达到 0.89,优于纯 VLA 的 0.64,同时在域内表现依然强劲(0.97 vs. 0.96)。

- 成功执行复杂工具使用任务:真空吸尘(稳定抓握与动力控制)和面包分发(精确物体转移),展示了长时程操作能力。

- 在可泛化拾取-放置任务中,GR-Dexter 在基础设置下达到 0.93 的成功率,优于纯 VLA(0.87)和无跨体感数据的 GR-Dexter(0.85)。

- 在未见物体和未见指令场景下,GR-Dexter 分别取得 0.85 和 0.83 的成功率,显著优于基线方法,验证了通过精选视觉-语言与跨体感数据实现的鲁棒泛化能力。

结果表明,GR-Dexter 在长时程操作任务的域内与分布外设置下均取得高成功率。在基础设置中,GR-Dexter 成功率达 0.97,与纯 VLA 基线持平;而在包含未见布局的 OOD 设置下,GR-Dexter 保持 0.89 的高成功率,而纯 VLA 下降至 0.64,充分展示了其更强的泛化能力。

作者在可泛化拾取-放置任务上评估 GR-Dexter,与纯 VLA 基线及无跨体感数据的变体进行对比。结果表明,在包含已见物体的基础设置中,GR-Dexter 达到最高成功率 0.93,优于两个基线。在未见物体与未见指令设置下,GR-Dexter 分别保持 0.85 和 0.83 的成功率,充分展示了跨体感数据在提升鲁棒性方面的有效性。