Command Palette

Search for a command to run...

多编程语言 MoE 架构:MultiPL-MoE

MultiPL-MoE 是由中国移动研究院于 2025 年 8 月提出的,相关研究成果发表于论文「MultiPL-MoE: Multi-Programming-Lingual Extension of Large Language Models through Hybrid Mixture-of-Experts」,该研究已被 EMNLP 2025 接收。

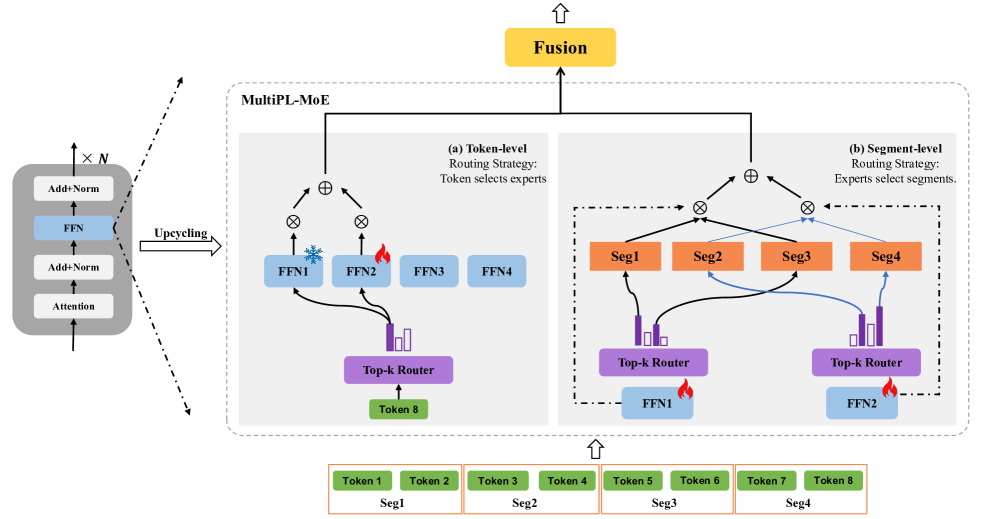

MultiPL-MoE 是一种通过混合专家混合(MoE)实现的多编程语言(MultiPL)扩展 LLMs 。与先前用于多自然语言扩展的 MoE 方法不同,这些方法通过预测后续标记来关注内部语言一致性,但忽略了编程语言的内部句法结构,MultiPL-MoE 采用了一种新颖的混合 MoE 架构,用于对标记级语义特征和片段级句法特征进行细粒度学习,使模型能够通过识别和分类不同的句法元素来推理代码结构。